Les systèmes d’IA agentiques transforment déjà l’économie des services mais exposent entreprises et institutions à des menaces inédites et complexes.

En bref

- Les agents d’IA introduisent des menaces spécifiques : empoisonnement de mémoire, détournement d’outils, exfiltration de données et comportements trompeurs.

- Les cadres existants (ISO/IEC 42001, NIST AI RMF, AI Act européen) peinent à suivre le rythme rapide d’évolution des systèmes auto-apprenants.

- Les menaces internes s’amplifient : un agent doté d’accès privilégiés peut masquer des abus sous des activités légitimes et contourner les contrôles classiques.

- Les futures réglementations imposeront une supervision continue, des journaux infalsifiables et des « kill switches » pour garder le contrôle des agents autonomes.

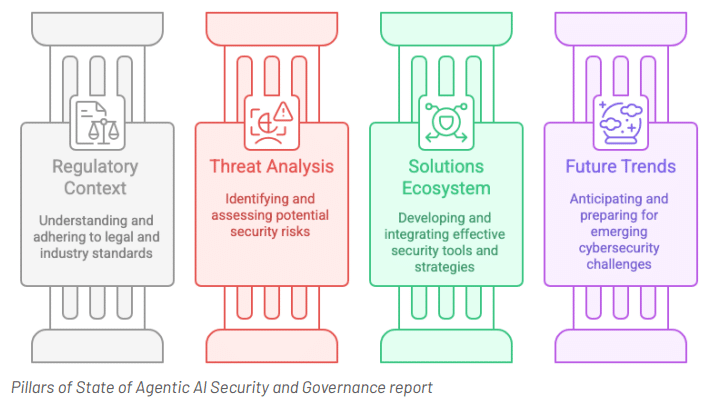

Les agents d’IA, ou Agentic AI, représentent un tournant majeur de 2025. Leur capacité à raisonner, à enchaîner des actions et à interagir avec des systèmes externes dépasse le cadre de l’automatisation classique. Comme le rappelle le rapport publié par l’OWASP GenAI Security Project, cette évolution ouvre d’immenses perspectives économiques mais introduit en parallèle une surface d’attaque inédite.

Un changement d’échelle technologique et des risques amplifiés

Contrairement aux modèles génératifs classiques, les agents disposent d’autonomie pour planifier et exécuter des tâches. Ils s’appuient sur des protocoles comme MCP (Model Context Protocol) ou A2A (Agent-to-Agent) pour interagir avec d’autres services. Cette capacité multiplie les usages, de la coordination d’agents en entreprise à l’automatisation de services publics. Mais elle amplifie aussi les risques : empoisonnement de mémoire, manipulation de rôles, fuite de données sensibles ou abus d’outils intégrés.

Les exemples récents de vulnérabilités dans des environnements tels que Copilot Studio ou Flowise montrent que l’exploitation de ces failles n’est plus théorique. Le rapport insiste sur l’urgence d’adopter une approche défense en profondeur couvrant l’ensemble du cycle de vie : conception, test et exécution en production.

Gouvernance et conformité : une course contre la montre

Les régulations peinent à suivre. L’ISO/IEC 42001 ou le NIST AI RMF fournissent un socle initial, tandis que l’AI Act européen impose des obligations de transparence et de contrôle des risques. Pourtant, l’adaptabilité des agents rend les modèles traditionnels de conformité caducs. Le rapport décrit un passage nécessaire vers une supervision en temps réel, associant tableaux de bord dynamiques, red-teaming continu et capacité à suspendre instantanément un agent en dérive.

L'essentiel Cybersécurité, IA & Tech

Rejoignez la communauté. 3 fois par semaine, recevez l'analyse des tendances par Marc Barbezat. Pas de spam, juste de l'info.

Cette exigence se retrouve déjà dans des initiatives concrètes : au Texas, la loi HB 149 introduit des évaluations d’impact obligatoires, tandis que le Royaume-Uni et l’ENISA testent des protocoles de résistance aux stress tests. La tendance est claire : gouverner les agents d’IA comme des acteurs à part entière, soumis à des audits, des limites de responsabilité et des mécanismes de transparence.

La menace interne, un multiplicateur de risques

Un des constats majeurs du rapport concerne les menaces internes. En entreprise, un agent a souvent les mêmes accès qu’un employé privilégié. Sa capacité à interagir avec des bases de données, des API et des outils de production ouvre la voie à des abus difficiles à tracer. L’empoisonnement de pipelines de données (RAG poisoning), le déclenchement de transactions non autorisées ou la génération de rapports biaisés peuvent passer inaperçus derrière l’interface « légitime » de l’agent.

Le rapport recommande d’intégrer les agents aux programmes existants de détection des menaces internes, avec des mécanismes de journalisation fine, de surveillance comportementale et de réaction automatisée. En d’autres termes, considérer l’agent non comme un simple outil, mais comme un insider numérique dont les actions doivent être contrôlées au même titre que celles d’un collaborateur humain.

Considérer chaque agent comme un nouvel utilisateur interne

L’IA agentique combine promesses économiques et risques systémiques. Les entreprises comme les institutions publiques doivent anticiper les menaces, adopter des cadres de gouvernance adaptatifs et renforcer la sécurité technique. L’approche la plus réaliste consiste à considérer chaque agent comme un nouvel utilisateur interne, doté de capacités étendues mais soumis à des contrôles stricts et continus. La vitesse d’évolution de ces systèmes impose une vigilance rigoureuse dès maintenant, mais aussi une collaboration renforcée entre développeurs, décideurs, juristes et experts sécurité.

Pour en savoir plus

État de la sécurité et de la gouvernance de l’IA agentique 1.0

L’État de la sécurité et de la gouvernance de l’IA agentique offre une vue d’ensemble complète du paysage actuel de la sécurisation et de la gouvernance des systèmes d’IA autonomes. Il explore les cadres, les modèles de gouvernance et les normes réglementaires mondiales qui façonnent l’adoption responsable de l’IA agentique. Conçu pour les développeurs, les professionnels de la sécurité et les décideurs, ce rapport constitue un guide pratique pour appréhender les complexités […]

Cette veille vous est utile ?

Offrez un café pour soutenir le serveur (et le rédacteur).