Recevez les nouveaux articles DCOD directement sur Telegram.

🔔 S’abonner au canal DCODLe National Institute of Standards and Technology (NIST) du ministère américain du commerce a publié son cadre de gestion des risques liés à l’intelligence artificielle.

Le cadre a pour objectif de maximiser les avantages de la technologie de l’IA tout en réduisant les risques de dommages pour les individus, les groupes, les communautés, les organisations et la société.

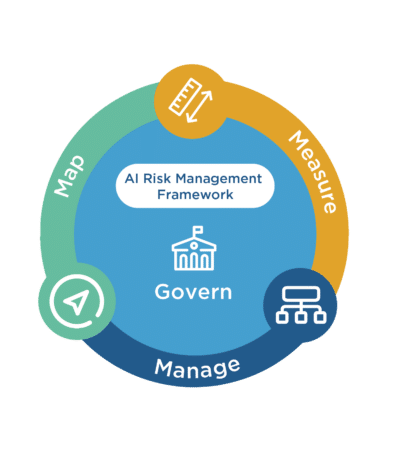

Il se divise en deux parties : la première partie explique comment les organisations peuvent cadrer les risques liés à l’IA et décrit les caractéristiques des systèmes d’IA dignes de confiance, tandis que la seconde partie, qui constitue le cœur du cadre, décrit quatre fonctions spécifiques (gouverner, cartographier, mesurer et gérer) pour aider les organisations à gérer les risques des systèmes d’IA dans la pratique.

Le nouveau cadre devrait « accélérer l’innovation et la croissance de l’IA tout en faisant progresser – plutôt que de restreindre ou de nuire – les droits civils, les libertés civiles et l’équité pour tous. »

Don Graves, secrétaire adjoint au commerce

Le NIST a annoncé travailler avec la communauté de l’IA pour mettre à jour régulièrement ce cadre de gouvernance.

Le cadre de gestion des risques du NIST vise à améliorer la fiabilité de l’intelligence artificielle

De nouvelles directives visent à cultiver la confiance dans les technologies de l’IA et à promouvoir l’innovation en matière d’IA tout en atténuant les risques

💡 Ne manquez plus l'essentiel

Recevez les analyses et tendances cybersécurité directement dans votre boîte mail.

Offrez un café pour soutenir cette veille indépendante.

☕ Je soutiens DCOD💡 Note : Certaines images ou extraits présents dans cet article proviennent de sources externes citées à des fins d’illustration ou de veille. Ce site est indépendant et à but non lucratif. 👉 En savoir plus sur notre cadre d’utilisation.

Vous appréciez nos analyses ?

Soutenez DCOD en offrant un café ☕