brève actu

Aardvark, nouveau modèle d’OpenAI, automatise la détection et la correction des vulnérabilités de code pour renforcer la sécurité logicielle et accélérer la protection des systèmes.

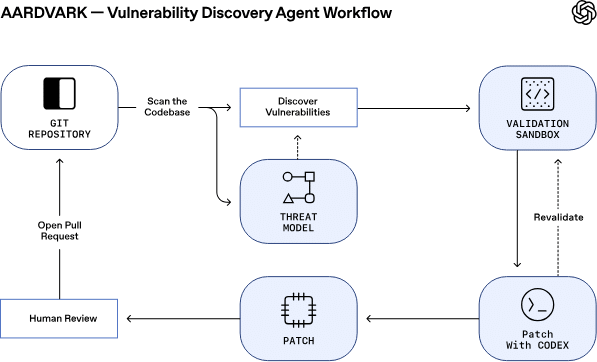

OpenAI a récemment introduit Aardvark, un modèle d’intelligence artificielle axé sur la sécurité, alimenté par ChatGPT-5. Ce modèle innovant vise à automatiser la détection et la correction des bugs dans le code, offrant ainsi une solution proactive pour renforcer la sécurité logicielle. En phase Beta sur invitation, Aardvark scanne continuellement les dépôts de code source pour identifier et corriger les vulnérabilités. Cette approche permet non seulement de prévenir les failles potentielles, mais aussi d’accélérer le processus de sécurisation en réduisant la dépendance aux méthodes d’analyse traditionnelles.

Un modèle autonome pour une sécurité renforcée

Selon CyberScoop, Aardvark se distingue par sa capacité à émuler le comportement d’un chercheur en sécurité. Contrairement aux techniques traditionnelles telles que le fuzzing, Aardvark utilise un raisonnement alimenté par un modèle de langage pour comprendre le comportement du code et identifier les failles. Cette méthode permet de détecter jusqu’à 92 % des vulnérabilités connues et introduites de manière synthétique dans des dépôts de référence. Outre la détection, Aardvark est capable de créer des modèles de menace, d’annoter le code problématique et de proposer des correctifs pour validation humaine. En facilitant la découverte précoce des vulnérabilités et en proposant des solutions claires, Aardvark promet de renforcer la sécurité sans freiner l’innovation.

Comme le rapporte The Hacker News, Aardvark est également conçu pour être accessible aux développeurs et aux équipes de sécurité, leur permettant de signaler et de corriger efficacement les vulnérabilités. En adoptant une approche proactive, OpenAI espère élargir l’utilisation d’Aardvark au-delà de ses partenaires de recherche initiaux. L’outil est particulièrement prometteur pour les dépôts de code open source non commerciaux, qui peuvent utiliser gratuitement le scanner. En outre, OpenAI a récemment ajusté son processus de divulgation coordonnée des vulnérabilités pour mieux s’adapter aux besoins des développeurs, soulignant ainsi son engagement envers la sécurité de l’écosystème.

L'essentiel Cybersécurité, IA & Tech

Rejoignez la communauté. 3 fois par semaine, recevez l'analyse des tendances par Marc Barbezat. Pas de spam, juste de l'info.

Les modèles d’IA comme Aardvark et XBOW, une autre initiative de sécurité IA, illustrent le potentiel croissant des modèles de langage pour automatiser la recherche de vulnérabilités. Bien que XBOW ait démontré son efficacité pour traiter un grand volume de bugs de faible impact, il cherche également à s’attaquer à des bugs plus complexes.

Malgré ces obstacles, l’automatisation de la gestion des vulnérabilités de faible gravité offre une valeur reconnue en libérant les experts humains pour se concentrer sur des failles plus complexes. En définitive, l’innovation continue dans ce domaine pourrait transformer la manière dont la sécurité logicielle est abordée, en rendant les systèmes plus sûrs et plus résilients face aux menaces émergentes.

Cette veille vous a été utile ?

Un café = un mois de serveur. Aidez DCOD à rester gratuit et indépendant.