Microsoft a révélé un groupe cybercriminel, Storm-2139, exploitant illégalement des services d’IA générative d’Azure OpenAI pour créer du contenu illicite.

Imaginez un instant que des outils d’intelligence artificielle avancés soient détournés pour générer du contenu illicite, contourner les garde-fous de la technologie et faciliter des activités criminelles.

C’est précisément ce que Microsoft a révélé en février 2025, en exposant un réseau organisé exploitant les services d’IA générative d’Azure OpenAI. Ce groupe malveillant a utilisé des identifiants compromis pour accéder illégalement à des comptes et modifier les modèles d’IA afin de produire du contenu interdit. Parmi ces usages figurent la création d’images synthétiques illicites et le développement d’outils facilitant des cyberattaques, comme l’automatisation du phishing et l’élaboration de fausses identités numériques.

Un réseau mondial de cybercriminels identifié

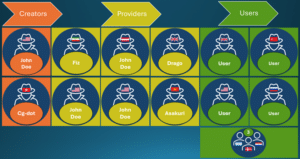

Microsoft a identifié un groupe cybercriminel, surnommé Storm-2139, impliqué dans l’exploitation illicite des services d’IA générative. Ce groupe mondial est structuré en trois catégories d’acteurs :

L'essentiel Cybersécurité, IA & Tech

Rejoignez la communauté. 3 fois par semaine, recevez l'analyse des tendances par Marc Barbezat. Pas de spam, juste de l'info.

- Les créateurs, qui développent des outils sophistiqués permettant de contourner les protections des IA, notamment en exploitant des clés API volées ou des comptes compromis pour accéder illégalement aux plateformes d’IA.

- Les fournisseurs, qui modifient ces outils et les distribuent à des utilisateurs malveillants sous forme de services payants, permettant à n’importe quel cybercriminel d’accéder à ces technologies sans compétences avancées.

- Les utilisateurs finaux, qui exploitent ces outils pour générer des contenus synthétiques illégaux, allant de la désinformation automatisée à la création d’images à caractère sexuel explicite de célébrités sans leur consentement.

Microsoft a identifié plusieurs acteurs clés de Storm-2139 issus de divers pays, notamment l’Iran, le Royaume-Uni, Hong Kong et le Vietnam. Ces individus sont accusés d’avoir violé les conditions d’utilisation des services Azure OpenAI en accédant illégalement à des comptes compromis et en revendant ces accès à des tiers malintentionnés.

L’exploitation malveillante des services d’IA par Storm-2139 illustre un défi croissant : la sécurisation des technologies émergentes face à des menaces toujours plus sophistiquées. Pour contrer ces abus, une vigilance accrue et une collaboration entre les acteurs du numérique et les autorités sont essentielles. Cette affaire souligne également l’importance de mesures proactives pour garantir une utilisation éthique et sécurisée de ces technologies.

Impacts et enjeux : la sécurité des services d’IA en question

L’affaire Storm-2139 met en lumière les défis croissants auxquels sont confrontés les fournisseurs de services d’IA pour prévenir les abus. L’exploitation d’Azure OpenAI par ce réseau illustre comment même les systèmes les plus avancés peuvent être détournés si des cybercriminels parviennent à voler des identifiants ou à contourner les mesures de sécurité existantes.

L’impact de telles activités ne se limite pas à Microsoft. Ces attaques compromettent l’intégrité des services cloud et érodent la confiance des utilisateurs. En permettant la création de contenu nuisible à grande échelle, elles exposent aussi les victimes à des risques accrus de harcèlement, de manipulation et d’usurpation d’identité.

En parallèle, cette situation soulève des questions juridiques complexes. Qui est responsable lorsqu’une IA est détournée à des fins criminelles ? Les fournisseurs d’IA doivent-ils être plus strictement réglementés pour empêcher de tels abus ? Ces questions restent ouvertes et nécessitent une réflexion collective entre gouvernements, entreprises et experts en cybersécurité.

Pistes de réflexion et recommandations

Pour prévenir de telles attaques, plusieurs mesures peuvent être mises en place :

- Renforcement des mesures de sécurité : Microsoft et d’autres fournisseurs doivent développer des systèmes avancés de détection et de prévention des abus, notamment en surveillant activement les modèles d’IA pour repérer tout détournement de leur usage initial.

- Sensibilisation des utilisateurs : Informer les entreprises et les particuliers sur les risques liés à la compromission de leurs identifiants et promouvoir l’utilisation de l’authentification multi-facteurs pour sécuriser les accès.

- Collaboration internationale : Renforcer la coopération entre entreprises technologiques et autorités judiciaires pour identifier et démanteler les groupes cybercriminels opérant à l’échelle mondiale.

- Mise en place de politiques claires : Les plateformes doivent adopter et faire respecter des politiques strictes d’utilisation de l’IA, tout en améliorant la transparence sur leurs mécanismes de modération.

Une riposte judiciaire et technique

Microsoft n’a pas seulement dénoncé ce réseau ; l’entreprise a également engagé des poursuites judiciaires contre les individus impliqués et pris des mesures pour perturber leurs activités. L’intervention a conduit à des conflits internes au sein de Storm-2139, certains membres se renvoyant mutuellement la responsabilité et exposant des informations sensibles.

En parallèle, Microsoft a mis en place des stratégies de neutralisation. L’entreprise a collaboré avec des fournisseurs de services cloud et d’hébergement pour suspendre les serveurs et infrastructures utilisés par Storm-2139, freinant ainsi leurs activités. Ces actions, combinées à la publication d’informations sur le fonctionnement du réseau criminel, visent à limiter l’impact de ce type de menace sur le long terme.

L’avenir de la cybersécurité face à l’IA

L’affaire Storm-2139 met en lumière un défi grandissant : la sécurisation des systèmes d’intelligence artificielle face aux cybercriminels. Plus les outils d’IA se démocratisent, plus ils deviennent des cibles potentielles pour les hackers cherchant à les exploiter à des fins malveillantes.

Les régulateurs et les entreprises technologiques devront travailler de concert pour garantir que ces systèmes restent sécurisés et ne deviennent pas des vecteurs d’abus. Il est également crucial que les utilisateurs, qu’ils soient entreprises ou particuliers, soient informés des risques et encouragés à adopter des pratiques de cybersécurité renforcées.

L’action de Microsoft contre Storm-2139 pourrait servir de modèle pour d’autres entreprises confrontées à des menaces similaires. Une réponse rapide, associant action judiciaire, suspension des infrastructures criminelles et transparence sur les menaces, semble être la clé pour minimiser l’impact des cyberattaques impliquant l’IA.

Pour en savoir plus

Perturber un réseau mondial de cybercriminalité en abusant de l’IA générative

Dans une plainte modifiée suite à un récent litige civil, Microsoft désigne les principaux développeurs d’outils malveillants conçus pour contourner les protections des services d’IA générative, notamment Azure OpenAI Service. Nous poursuivons cette action en justice contre les défendeurs identifiés afin de mettre fin à leurs agissements, de poursuivre le démantèlement de leurs activités illicites et de dissuader quiconque tente d’instrumentaliser notre technologie d’IA.

Microsoft a démantelé un réseau mondial de cybercriminalité abusant du service Azure OpenAI

Microsoft a dévoilé quatre individus à l’origine d’un système d’abus Azure utilisant un accès GenAI non autorisé pour créer du contenu nuisible. Microsoft a partagé les noms de quatre développeurs d’outils malveillants conçus pour contourner les garde-fous des services d’IA générative, notamment…

(Re)découvrez également:

Microsoft augmente les récompenses du Bug Bounty de Copilot AI

Microsoft renforce son programme bug bounty pour Copilot AI en augmentant les récompenses et en élargissant les catégories de vulnérabilités ciblées.

Sécurité des modèles LLM : comment les hackers contournent leurs protections

Attention, les modèles de langage de grande taille (LLM) sont vulnérables à diverses techniques d’attaque contournant leurs filtres de sécurité.

Expertise Cyber en accès libre.

Pas de paywall, pas d'abonnement caché. Votre soutien permet de maintenir cette gratuité.