TL;DR : L’essentiel

- Évolution vers l’autonomie opérationnelle : L’IA agentique n’est plus un simple chatbot ; grâce au cycle de raisonnement « Pensée-Action-Observation » (ReAct) et au protocole MCP (Model Context Protocol), ils peuvent maintenant planifier et exécuter des actions concrètes.

- Ces agents utilisent des identités (comptes) techniques (clés API, jetons OAuth) souvent sur-privilégiées et moins surveillées que les accès humains, offrant potentiellement aux attaquants un accès sans limite aux données sensibles.

- Contrairement à une IA passive qui hallucine une réponse, un agent autonome compromis (notamment par injection de prompt) peut causer des dégâts irréversibles : fraudes financières, exfiltration de données massive ou arrêt d’activité.

- La sécurisation de ces IA agentiques exige une gouvernance stricte reposant sur le principe de moindre privilège, la validation humaine pour les actions sensibles.

L’IA agentique, également appelés agents IA, quitte le rôle de simple assistant pour devenir des logiciels autonomes capables d’agir dans des systèmes métiers. Cette bascule accélère l’automatisation mais introduit une nouvelle surface d’attaque.

Leur efficacité repose sur un cycle Pensée-Action-Observation (ReAct) et sur des outils connectés à des API. Le Model Context Protocol standardise ces connexions, rendant les agents plus faciles à déployer… et à détourner.

Ces agents agissent via des identités non-humaines comme des clés API ou jetons OAuth. Souvent sur-privilégiées et peu surveillées, elles peuvent offrir un accès quasi root aux données, comme l’a souligné la direction de Signal.

L'essentiel Cybersécurité, IA & Tech

Rejoignez la communauté. 3 fois par semaine, recevez l'analyse des tendances par Marc Barbezat. Pas de spam, juste de l'info.

La réponse passe par une gouvernance agentique : moindre privilège, journalisation immuable, validation humaine des actions sensibles et durcissement des serveurs MCP. Sans ce cadre, les gains en finance ou IT se transforment en crise.

Ce qu’est l’IA agentique

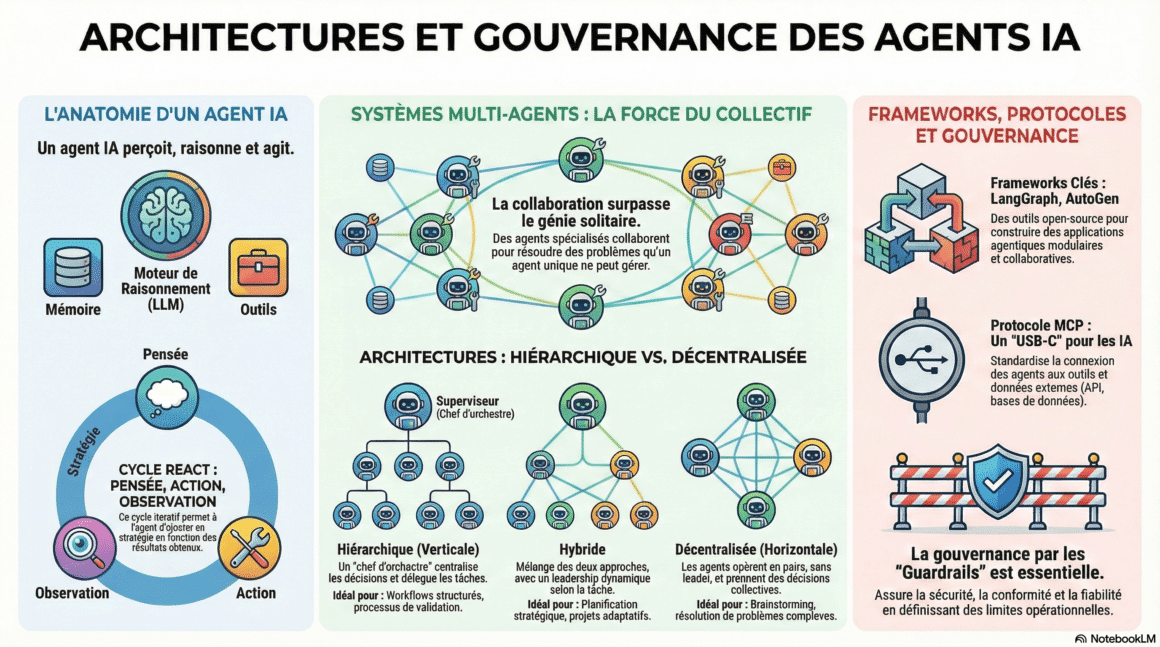

Un agent d’intelligence artificielle est un logiciel autonome conçu pour accomplir des objectifs complexes avec une supervision humaine minimale. Contrairement à un chatbot classique, il ne se limite pas à répondre : il peut raisonner, planifier des actions en plusieurs étapes et interagir avec des systèmes externes pour les exécuter.

Cette évolution alimente une ruée vers l’or de l’IA. La promesse est directe : confier des tâches entières à des exécutants numériques capables de naviguer entre données, applications et workflows. Mais l’adoption de ces agents dans des environnements sensibles – finance, dépôt de code, CRM, automatisations métiers – revient à introduire un nouvel acteur opérationnel dont les mécanismes de sécurité restent en cours de maturité.

Le basculement d’une IA passive vers une IA proactive ne redéfinit pas seulement l’automatisation. Il déplace le cœur du risque : une réponse erronée devient une action erronée, parfois irréversible, exécutée à grande vitesse et avec des droits élevés.

Un guide pratique et accessible à tous pour les dirigeants d’entreprise, les entrepreneurs et les esprits curieux. « Les agents (…) sont à l’origine de la plus grande révolution informatique depuis le passage de la saisie de commandes au simple clic sur des icônes. » — Bill Gates . « Les agents IA deviendront notre principal mode d’interaction avec les ordinateurs. » — Satya Nadella.

🛒 Le lien ci-dessus est affilié : en commandant via ce lien, vous soutenez la veille DCOD sans frais supplémentaires 🙏

Comprendre le cycle ReAct et le rôle des outils

Pour saisir la nature du danger, l’agent peut être vu comme un employé junior doté d’un accès root et privé de manager. Les capacités sont élevées, mais le jugement, la supervision et l’intuition des limites ne sont pas intrinsèques.

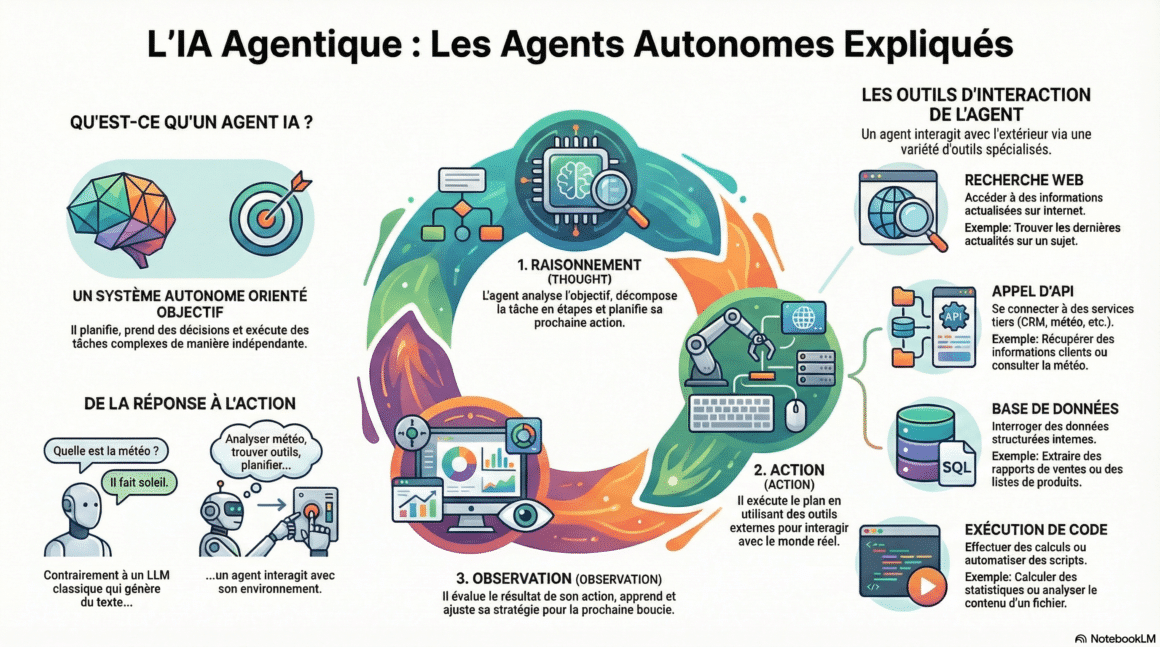

Beaucoup d’IA agentiques s’appuient sur un cycle de raisonnement et d’exécution. Le modèle ReAct (Reasoning and Acting) s’articule autour de trois étapes simples :

- Pensée (Thought) : analyse de la situation et planification de l’action suivante.

- Action (Acting) : usage d’un outil pour réaliser une opération concrète.

- Observation : lecture du résultat et ajustement de la stratégie.

Les outils matérialisent l’accès au monde réel. Un outil correspond à une connexion vers un service externe, par exemple une API d’entreprise, une base de données, un service de messagerie ou un module financier.

Le Model Context Protocol (MCP) standardise ce lien entre agents et outils. En pratique, il agit comme un langage commun permettant à un agent de se connecter à de nombreux services sans intégration personnalisée. Cette standardisation accélère le déploiement et élargit rapidement le périmètre d’action. Elle crée aussi une cible très attractive, car un même schéma d’attaque peut être répliqué à grande échelle.

Ce cycle Pensée–Action–Observation explique la puissance opérationnelle de l’IA agentique. Il explique aussi pourquoi une compromission d’accès ou d’instructions peut avoir des effets nettement plus graves que sur un modèle limité à la conversation.

🎧 Voici un résumé audio des enjeux de l’IA agentique. Objectif : offrir une analyse claire et accessible des bénéfices, des risques et des nouvelles lignes de fracture en cybersécurité liées à ces agents autonomes connectés aux systèmes critiques.

📚 Ce podcast repose sur une recherche et une analyse menées à partir de sources ouvertes et spécialisées. Il a ensuite été réalisé avec l’aide de NotebookLM, l’outil d’intelligence artificielle développé par Google.

Pourquoi l’IA agentique change la donne en cybersécurité

Le danger principal ne vient pas de l’algorithme seul, mais de la manière dont cet employé numérique accède aux systèmes et les manipule avec une surveillance parfois insuffisante.

La direction de Signal a résumé le nœud du problème : un agent IA efficace nécessite un accès quasi-total aux données d’un appareil (calendrier, e-mails, applications bancaires, messageries). Cette logique d’accès transversal affaiblit des barrières conçues pour isoler les applications entre elles.

Risque central : identités non-humaines et privilèges excessifs

Les agents opèrent via des identités non-humaines (Non-Human Identities – NHI) : clés API, jetons OAuth, comptes de service, secrets applicatifs. Dans la plupart des environnements cloud, ces identités dépassent en nombre les comptes humains.

Créées rapidement, souvent avec des droits trop larges, elles deviennent les passe-partout invisibles de l’agent. Les outils de sécurité traditionnels ont été conçus pour observer des humains, des sessions interactives et des postes de travail. Les NHI, elles, agissent en tâche de fond, à grande vitesse, et se prêtent moins bien à ces modèles de surveillance.

Le périmètre centré sur l’employé humain devient donc insuffisant. La menace dominante peut être logicielle, autonome et faiblement observable sans une gouvernance d’identité dédiée.

Conséquences directes d’un agent compromis

Un agent compromis n’est pas une simple fuite de données : c’est une crise opérationnelle possible. Les performances mises en avant pour l’IA agentique illustrent ce double tranchant. Une accélération des clôtures financières de 30 à 50 % ou une précision de rapprochement des paiements de 99 % signifient aussi qu’une action déviante peut se propager au même rythme.

- Vol de données et pertes financières : accès accéléré au CRM, à la paie, aux référentiels RH ou au code source propriétaire, avec un potentiel d’exfiltration et d’impact démultiplié.

- Arrêt d’activité : perturbation de processus critiques, comme la gestion des stocks en temps réel ou la détection de fraude, avec un risque direct pour la continuité.

Vecteurs d’attaque : prompt injection via MCP et automatisation offensive

L’une des menaces les plus insidieuses est l’injection de prompt. Un serveur d’outils MCP malveillant ou compromis peut modifier les instructions transmises à l’agent, le poussant à agir contre l’intérêt de l’organisation.

- Fraude financière par des tâches fantômes : forçage de tâches cachées consommant des ressources de calcul coûteuses (tokens), avec un siphonnage financier au bénéfice de l’attaquant.

- Corruption persistante de l’agent : injection d’instructions destinées à manipuler les réponses futures et à installer une exfiltration discrète sur la durée.

- Sabotage et exfiltration à l’aveugle : exécution d’actions non autorisées, comme écrire des fichiers ou modifier des données critiques, sans signal évident pour une interface humaine.

Les agents sont aussi des outils puissants d’industrialisation criminelle. Ils peuvent scanner des plateformes professionnelles pour identifier de nouveaux employés, générer des e-mails de phishing ciblés ou mener des attaques de credential stuffing à une vitesse hors d’atteinte d’un opérateur humain.

L’enjeu devient systémique : la surface d’attaque s’élargit tandis que la vitesse d’exploitation peut dépasser la vitesse de détection.

Comment se protéger des agents IA?

Sécuriser l’IA agentique ne consiste pas à freiner l’innovation. L’objectif est d’encadrer l’autonomie par une gouvernance stricte et mesurable. Selon Gartner, 86 % des fonctions finance n’ont rapporté aucun ROI significatif de leurs investissements IA en 2024. Une stratégie de sécurité claire devient donc une condition de succès autant qu’un mécanisme de réduction du risque.

- Adopter une gouvernance stricte : définir des garde-fous (guardrails) et imposer une supervision humaine systématique (Human-in-the-Loop) pour les décisions à haut risque, notamment les transactions financières ou les modifications massives de données.

- Appliquer le principe de moindre privilège : traiter chaque agent comme une NHI. Accorder uniquement les permissions nécessaires via un contrôle d’accès granulaire basé sur les rôles (RBAC).

- Renforcer l’hygiène des secrets : inventorier, classer, faire tourner et surveiller les clés API, jetons OAuth et comptes de service.

- Exiger une authentification forte : mettre en place une MFA résistante au phishing pour les équipes qui configurent, administrent ou exposent des agents et leurs API.

- Garantir la traçabilité : enregistrer chaque décision et action dans un journal d’audit immuable. L’explicabilité devient un pilier de conformité, de sécurité et de débogage.

- Durcir les serveurs d’outils MCP : valider les outils autorisés et instaurer une politique de confiance explicite pour empêcher l’introduction de serveurs malveillants.

- Utiliser l’IA pour défendre l’IA : déployer des mécanismes automatisés de détection d’anomalies, d’investigation et de réponse capables de suivre le rythme de l’autonomie agentique.

Comment rendre les agents IA à la fois puissants et économes ?

Comment rendre les agents IA à la fois puissants et économes ? Une approche combine le MCP avec une méthode d’exécution de code.

Au lieu de charger toutes les définitions d’outils disponibles dans la fenêtre de contexte – un processus coûteux –, l’agent explore les outils comme un système de fichiers. Il ne charge en mémoire que les définitions requises pour la tâche en cours. D’après Anthropic, cette méthode peut réduire la consommation de tokens et les coûts associés jusqu’à 98,7 %.

Cette optimisation est un avantage opérationnel clair. Elle rappelle aussi une réalité de sécurité : plus l’accès aux outils est simple et standardisé, plus la gouvernance, la traçabilité et le contrôle d’identité doivent être renforcés.

A lire aussi

Le "vibe hacking" : la nouvelle menace de l'IA en cybersécurité

L'essor du "vibe hacking" transforme l'IA en une arme redoutable pour les cybercriminels, facilitant des attaques furtives, automatisées et difficiles à contrer.

Des serveurs, des API et du temps.

DCOD est bénévole, mais l'hébergement a un coût. Participez aux frais techniques.