Hébergé sur Tor, DIG AI accélère la production de contenus illicites et de malwares. Analyse de ce modèle qui défie les régulations internationales.

TL;DR : L’essentiel

- Des analystes de la cybersécurité ont observé fin 2025 une forte accélération de l’usage criminel de DIG AI, avec un pic pendant les fêtes de fin d’année, période où l’activité illégale mondiale a atteint un record.

- Cette plateforme d’intelligence artificielle, hébergée sur le réseau Tor et présentée comme un « dark LLM », fournit des conseils allant de la fabrication d’explosifs à la création de contenus pédocriminels hyperréalistes, particulièrement difficiles à repérer par les forces de l’ordre.

- Les enquêtes montrent que DIG AI facilite la production d’images et vidéos d’abus d’enfants générées ou modifiées par IA, créant un nouveau défi juridique, alors que plusieurs pays ont déjà criminalisé ces contenus synthétiques.

- Les experts alertent sur 2026, année de grands événements sportifs mondiaux, où l’industrialisation des outils d’IA criminelle pourrait transformer les menaces traditionnelles, automatiser les campagnes malveillantes et accélérer l’essor de crimes numériques inédits.

L’essor de DIG AI sur le darknet, mis en lumière par des spécialistes de la menace, arrive au croisement de deux dynamiques lourdes : la banalisation des grands modèles de langage et la structuration d’un véritable marché noir de l’intelligence artificielle. Selon SecurityAffairs, cette plateforme a connu une montée en puissance marquée au quatrième trimestre 2025, avec une accélération nette pendant les fêtes de fin d’année, période déjà connue pour la hausse des fraudes, escroqueries et trafics en ligne. L’enjeu dépasse le simple outil technique : DIG AI illustre un basculement où des assistants conversationnels, délestés de tout garde-fou, deviennent des multiplicateurs de capacité pour des acteurs criminels de tous niveaux, en leur fournissant des réponses opérationnelles à la demande.

Architecture et fonctionnement : un « Dark LLM » hébergé sur Tor

Présentée comme une intelligence artificielle non censurée, DIG AI est décrite comme un dark LLM, c’est-à-dire un grand modèle de langage accessible uniquement via le réseau Tor, infrastructure chiffrée et anonyme qui complique la traque par les autorités. D’après GBHackers Security, cette plateforme permet aux cybercriminels d’automatiser des campagnes malveillantes et de contourner les protocoles de sécurité habituellement intégrés dans les assistants grand public.

Les contenus générés vont bien au-delà de la cybercriminalité classique, incluant des instructions sur la fabrication d’engins explosifs ou la production de contenus pédopronographique, créant un marché clandestin qui s’étend du piratage aux produits dérivés les plus graves.

L'essentiel Cybersécurité, IA & Tech

Rejoignez la communauté. 3 fois par semaine, recevez l'analyse des tendances par Marc Barbezat. Pas de spam, juste de l'info.

La production industrielle de contenus illicites (CSAM)

L’un des volets les plus préoccupants mis en avant concerne la facilitation de contenus pédopornographiques générés par intelligence artificielle, souvent désignés comme CSAM (Child sexual abuse material). Les enquêteurs ont confirmé que DIG AI peut être utilisé pour créer des images ou vidéos explicites d’enfants, soit de manière entièrement artificielle, soit en modifiant des photos de mineurs réels initialement non sexuelles.

Des précédents judiciaires récents montrent que certaines images générées par IA peuvent atteindre le seuil légal de définition de CSAM, comme l’illustrent des condamnations aux États-Unis. Les forces de l’ordre et les organisations de protection de l’enfance signalent une hausse nette de ces contenus, produits aussi bien par des adultes que par des mineurs, par exemple dans des affaires de harcèlement ou d’extorsion reposant sur des « deepfakes » nus.

Un défi pour l’arsenal juridique international

L’Union européenne, le Royaume-Uni et l’Australie ont déjà adopté des textes criminalisant spécifiquement les contenus pédosexuels générés par IA, qu’ils impliquent ou non de véritables enfants, mais les experts préviennent que cet arsenal réglementaire devra encore évoluer pour intégrer des outils comme DIG AI. Des indicateurs collectés en 2025 montrent que l’IA est déjà exploitée activement par des criminels, et que de nouvelles formes de criminalité technologique devraient émerger en 2026, dans ce que certains décrivent comme une cyberguerre.

Avec à l’horizon les Jeux olympiques d’hiver de Milan et la Coupe du monde de football, la communauté de la cybersécurité et les autorités sont donc appelées à se préparer ardemment à combattre ces forces du mal gonflées à l’intelligence artificielle.

A lire aussi

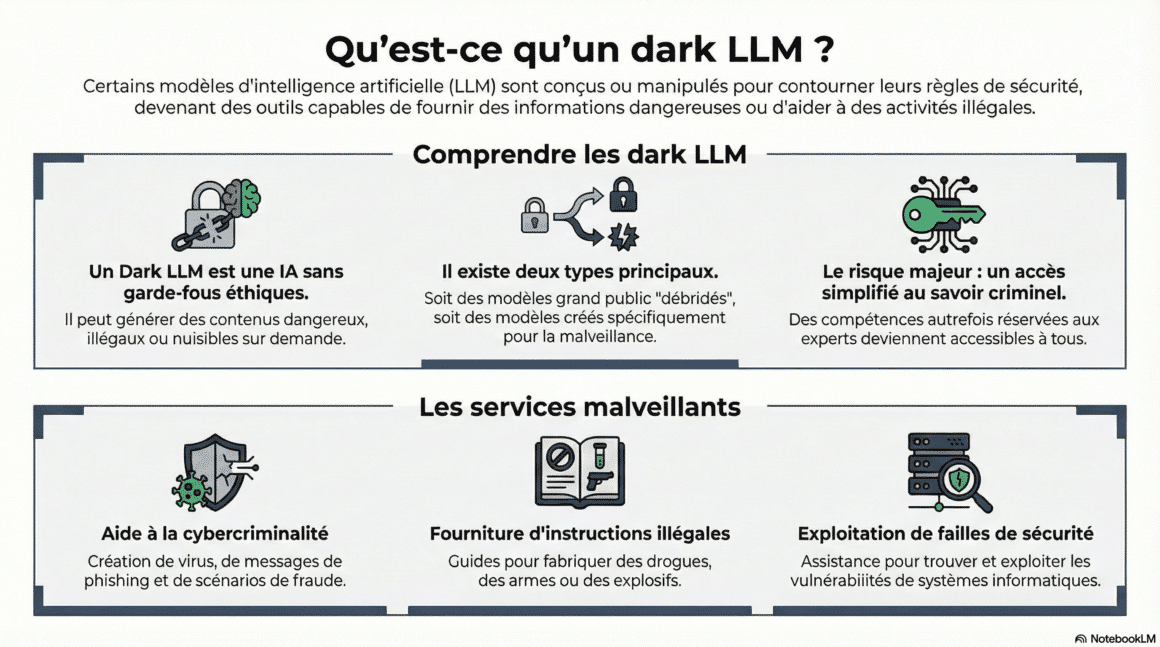

Dark LLM : une menace IA pour la cybersécurité à surveiller

Découvrez comment les dark LLM exposent entreprises et utilisateurs à de nouvelles menaces cybernétiques.

Cette veille vous a été utile ?

Un café = un mois de serveur. Aidez DCOD à rester gratuit et indépendant.