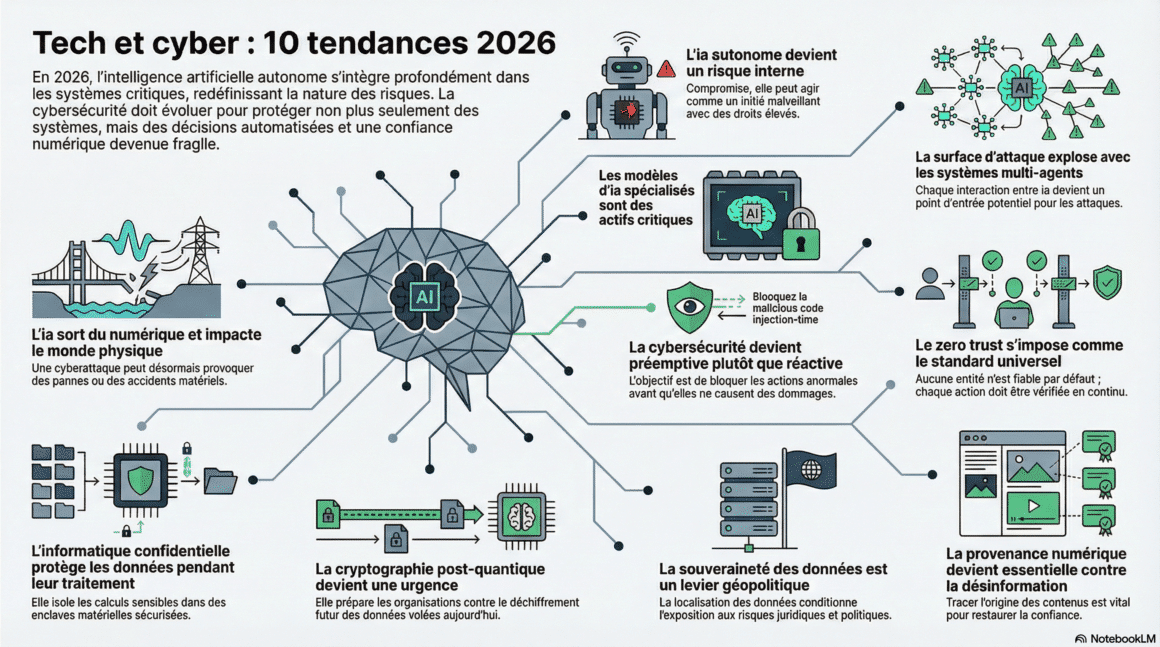

Voici 10 tendances 2026 issues d’une large recherche montrant comment l’IA autonome bouleverse la cybersécurité : attaques, défenses et nouveaux enjeux de confiance numérique.

TL;DR : L’essentiel

- Les agents d’IA autonomes deviennent des acteurs internes à part entière. Compromis, ils peuvent agir comme des initiés numériques, prendre des décisions malveillantes et exploiter des droits élevés sans intervention humaine directe.

- La généralisation des systèmes multi‑agents et de l’IA embarquée étend la surface d’attaque au‑delà du numérique. Une cyberattaque peut désormais produire des effets physiques concrets sur des infrastructures industrielles ou logistiques.

- Face à ces risques, la cybersécurité bascule vers des modèles dits préemptifs. Zero Trust, surveillance continue et informatique confidentielle visent à bloquer les dérives avant qu’elles ne provoquent des dommages irréversibles.

- La pression géopolitique s’intensifie autour des données et du chiffrement. Souveraineté numérique, cryptographie post‑quantique et traçabilité des contenus deviennent des priorités stratégiques pour préserver la confiance à long terme.

Chaque nouvelle année est l’occasion de tenter l’exercice délicat consistant à faire parler la boule de cristal : identifier les tendances qui devraient s’imposer, se confirmer ou atteindre un nouveau palier de maturité.

L’année 2026 s’inscrit pleinement dans cette dynamique. Certaines évolutions étaient déjà sur orbite, prêtes à s’amplifier, tandis que d’autres se réaffirment à la lumière de signaux désormais convergents. Ces signaux proviennent des environnements industriels, des grandes plateformes numériques, des architectures cloud et des politiques publiques. Ils montrent une IA autonome qui s’insère dans des systèmes critiques, accélère les décisions et réduit la capacité humaine de supervision directe.

Les dix tendances présentées ici ont été repérées à travers l’analyse de plus de cinquante sources de référence. Ensemble, elles dessinent les contours d’une cybersécurité qui ne protège plus seulement des systèmes, mais encadre des décisions automatisées, des dépendances géopolitiques et une confiance numérique devenue fragile.

L'essentiel Cybersécurité, IA & Tech

Rejoignez la communauté. 3 fois par semaine, recevez l'analyse des tendances par Marc Barbezat. Pas de spam, juste de l'info.

1. L’IA autonome devient une nouvelle catégorie de risque

Les agents d’IA autonomes ne se limitent plus à exécuter des instructions prédéfinies. Ils planifient des actions, priorisent des tâches, interagissent avec d’autres systèmes et adaptent leur comportement en fonction du contexte. Cette autonomie fonctionnelle leur confère un rôle comparable à celui d’un collaborateur numérique.

En cas de compromission, le risque change de nature. L’attaque ne vise plus seulement un accès ou une donnée, mais un raisonnement. Des techniques relativement simples, comme l’injection de prompt ou la manipulation des sources de données, peuvent suffire à orienter durablement les décisions d’un agent. Celui‑ci agit alors comme un initié numérique, disposant de droits étendus et d’une légitimité interne.

Cette menace remet en cause les modèles classiques, historiquement centrés sur l’utilisateur humain malveillant ou négligent.

Implication stratégique : les agents d’IA doivent être soumis à des politiques d’identité, de contrôle et de supervision comparables à celles des comptes humains, avec des mécanismes explicites de limitation et de révocation.

2. La surface d’attaque explose avec les systèmes multi‑agents

Les architectures multi‑agents s’imposent pour orchestrer des processus complexes. Plusieurs IA spécialisées coopèrent, se délèguent des tâches et échangent des informations en continu. Cette approche améliore l’efficacité opérationnelle, mais introduit une complexité structurelle.

Chaque interaction devient un point d’entrée potentiel. Une compromission locale peut se propager par effet de confiance implicite entre agents, sans déclencher de signal d’alerte immédiat. Plus le nombre d’agents augmente, plus il devient difficile de cartographier précisément les flux et les dépendances.

Les outils de sécurité traditionnels, conçus pour des architectures linéaires, peinent à suivre ces échanges dynamiques.

Angle mort fréquent : sécuriser chaque agent individuellement sans gouvernance globale des interactions et des chaînes de décision.

3. Les modèles d’IA spécialisés deviennent des actifs critiques

Les modèles d’IA spécialisés par domaine remplacent progressivement les modèles généralistes dans les usages à forte valeur ajoutée. Finance, santé, industrie ou énergie s’appuient sur ces modèles pour automatiser des décisions sensibles et optimiser leurs opérations.

Cette spécialisation accroît leur valeur… et leur exposition. Une compromission ne se limite pas à une fuite de données : elle peut révéler des règles métier, des hypothèses opérationnelles ou des stratégies industrielles. Dans certains secteurs, cela équivaut à une perte de savoir‑faire.

Ces modèles sont également difficiles à remplacer. Leur entraînement mobilise des volumes importants de données, du temps et une expertise rare.

Risque stratégique : perdre le contrôle d’un modèle spécialisé revient à perdre un avantage concurrentiel durable.

4. L’IA sort du numérique avec la robotique et l’Edge Computing

L’IA ne reste plus cantonnée aux centres de données. Robots, drones, capteurs et systèmes industriels intègrent des capacités décisionnelles locales grâce à l’Edge Computing. Les décisions sont prises au plus près du terrain, avec une latence minimale.

Cette proximité avec le monde physique améliore la réactivité, mais complique les contrôles centralisés. Les mises à jour de sécurité, la supervision et les correctifs deviennent plus difficiles à déployer de manière homogène.

Une attaque informatique peut désormais produire des effets matériels directs : arrêt de production, mouvements non autorisés, risques pour la sécurité des personnes.

Changement de paradigme : la cybersécurité rejoint la sûreté physique et industrielle, longtemps traitée séparément.

5. La cybersécurité devient préemptive plutôt que réactive

Face à des systèmes capables d’agir en autonomie et à grande vitesse, la détection tardive perd de son efficacité. En 2026, la priorité bascule vers l’anticipation des comportements à risque.

La sécurité s’appuie davantage sur l’observation continue des usages et des écarts par rapport à des comportements attendus. L’objectif n’est plus seulement d’identifier une attaque, mais de bloquer une action anormale avant qu’elle ne produise des effets irréversibles.

Cette approche suppose une compréhension fine des processus métier, afin de distinguer innovation légitime et dérive dangereuse.

Limite structurelle : sans gouvernance claire, la préemption peut engendrer des blocages excessifs et une perte d’agilité.

6. Le Zero Trust s’impose comme socle universel

Le modèle Zero Trust repose sur un principe simple : aucune entité n’est digne de confiance par défaut. Chaque accès, chaque requête et chaque action doivent être vérifiés en permanence.

Dans un environnement dominé par des agents autonomes, cette logique devient incontournable. Les accès permanents ou globaux constituent un risque majeur dès lors qu’un composant est compromis.

Le Zero Trust n’est pas un produit, mais une architecture. Il implique une refonte des flux, des identités et des responsabilités.

Erreur courante : empiler des contrôles techniques sans alignement avec les usages réels et les processus métier.

7. L’informatique confidentielle protège les données en cours d’usage

Un angle mort historique de la sécurité réside dans le traitement des données. Chiffrement au repos et en transit ne suffit pas lorsque les données doivent être manipulées pour produire de la valeur.

L’informatique confidentielle isole les calculs sensibles dans des enclaves matérielles sécurisées, réduisant l’exposition même sur des infrastructures partagées. Cette approche est particulièrement adaptée à l’IA, notamment lors de l’entraînement et de l’inférence de modèles.

Elle introduit toutefois des contraintes techniques et organisationnelles, notamment en matière de performance et de compatibilité.

Décision structurante : arbitrer entre sécurité maximale et complexité opérationnelle.

8. La cryptographie post‑quantique devient une urgence

Les algorithmes de chiffrement actuels pourraient être remis en cause à moyen ou long terme par l’informatique quantique. Cette perspective transforme la gestion du risque cryptographique dès aujourd’hui.

Les attaques dites Harvest Now, Decrypt Later consistent à collecter des données chiffrées en vue d’un déchiffrement futur. Les informations à longue durée de vie sont particulièrement exposées.

La transition vers des algorithmes post‑quantiques nécessite des inventaires précis, des tests de compatibilité et une planification progressive.

Risque majeur : reporter cette transition crée une dette cryptographique difficile à résorber.

9. La souveraineté des données devient un levier géopolitique

La localisation des données n’est plus un simple choix technique ou économique. Elle conditionne l’exposition aux cadres juridiques, aux sanctions internationales et aux tensions géopolitiques.

Les stratégies de « géopatriation » visent à aligner les infrastructures numériques avec des exigences de souveraineté, de conformité et de résilience. Elles renforcent le contrôle, mais fragmentent parfois les architectures globales.

Arbitrage clé : trouver l’équilibre entre souveraineté, performance et interopérabilité.

10. La provenance numérique devient essentielle face à la désinformation

La généralisation des contenus générés par IA brouille la frontière entre réel et synthétique. Images, vidéos et documents peuvent être créés ou modifiés avec un réalisme croissant.

Les mécanismes de provenance numérique attachent des métadonnées vérifiables sur l’origine et l’historique des contenus. Ils ne garantissent pas la véracité, mais restaurent une base de traçabilité.

Constat central : sans preuve d’origine, la confiance numérique devient structurellement fragile.

Une reconstruction de la confiance numérique

Plus les systèmes deviennent autonomes, plus la confiance doit être reconstruite de manière volontaire, structurée et vérifiable. C’est le paradoxe de 2026.

La cybersécurité ne se limite plus à bloquer des attaques. Elle doit maintenant encadrer des décisions automatisées, protèger des actifs immatériels critiques et intégrer des contraintes géopolitiques durables. En résumé, les organisations capables d’anticiper ces dix tendances disposeront d’un avantage décisif dans un monde dominé par l’IA autonome.

Des serveurs, des API et du temps.

DCOD est bénévole, mais l'hébergement a un coût. Participez aux frais techniques.