TL;DR : L’essentiel

- Deux extensions cumulant plus de 900 000 installations, dont « Chat GPT for Chrome », ont été identifiés en train d’exfiltrer massivement les conversations privées des utilisateurs de ChatGPT et DeepSeek vers des serveurs contrôlés par des attaquants.

- Sous couvert d’améliorer l’expérience utilisateur via une barre latérale, le malware demande l’accès à des « données analytiques anonymes » pour en réalité aspirer l’historique de navigation et le contenu intégral des chats toutes les 30 minutes.

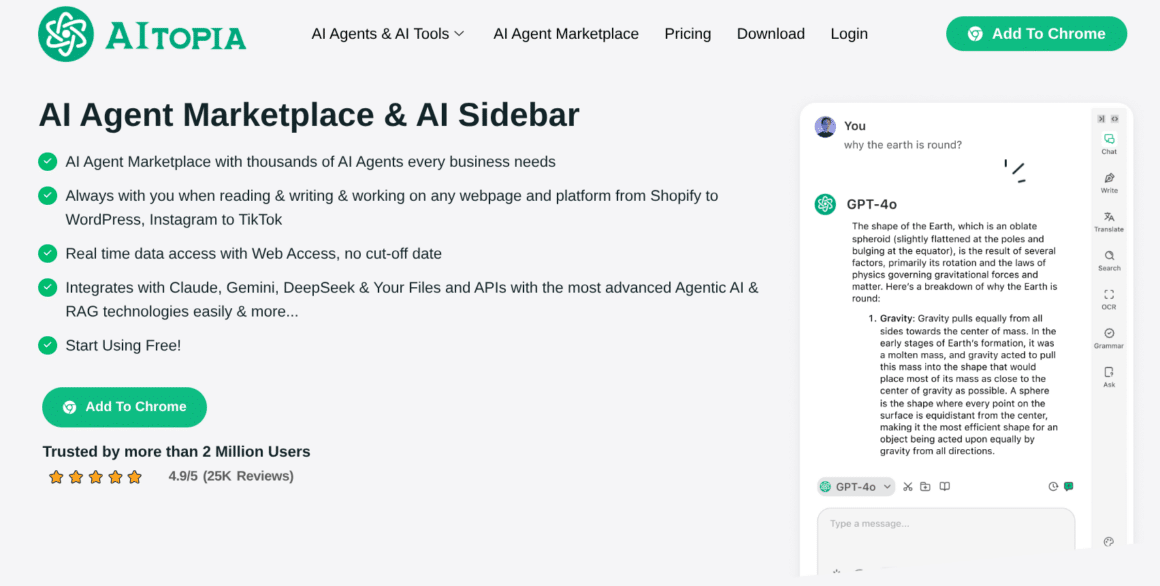

- Les attaquants usurpent l’identité de l’outil légitime AITOPIA en copiant son interface et ses fonctionnalités, allant jusqu’à utiliser la plateforme de développement IA « Lovable » pour héberger leurs fausses politiques de confidentialité et brouiller les pistes.

- Une mécanique vicieuse assure la persistance du logiciel espion : lorsqu’une victime tente de désinstaller l’une des extensions infectées, le code malveillant ouvre automatiquement un nouvel onglet incitant à télécharger l’autre version vérolée pour la remplacer.

L’ère de l’innocence dans l’utilisation des assistants IA via navigateur semble révolue. Une nouvelle menace silencieuse, qualifiée de « Prompt Poaching » (braconnage de requêtes), cible désormais spécifiquement la propriété intellectuelle et les données sensibles partagées avec les chatbots. Les chercheurs en cybersécurité ont mis au jour une campagne sophistiquée opérant au sein même du Chrome Web Store, exploitant la confiance des utilisateurs pour transformer leur navigateur en outil d’espionnage industriel. Contrairement aux malwares classiques qui bloquent ou détruisent, celui-ci écoute, enregistre et exporte les pensées numériques des victimes vers des serveurs tiers, exposant des stratégies d’entreprise, du code source propriétaire et des informations personnelles identifiables.

Usurper la confiance pour siphonner le code source

L’attaque repose sur une stratégie de mimétisme quasi parfaite. Les deux extensions incriminées, « Chat GPT for Chrome with GPT-5, Claude Sonnet & DeepSeek AI » et « AI Sidebar with Deepseek… », se font passer pour une application légitime nommée AITOPIA. Une fois installées, elles demandent à l’utilisateur de valider la collecte de données de navigation prétendument anonymes pour améliorer le service. C’est à cet instant précis que le piège se referme.

Techniquement, le logiciel malveillant ne se contente pas d’observer. Il génère un identifiant utilisateur unique (gptChatId) et surveille activement les URL visitées. Dès que le navigateur accède à un domaine contenant « chatgpt » ou « deepseek », le script scrute les éléments spécifiques du DOM (la structure de la page web) pour extraire le texte des échanges. Comme le détaille OX Security, ces données, incluant les identifiants de session, sont stockées localement avant d’être encodées en base64 et exfiltrées par paquets toutes les demi-heures vers des domaines externes. L’utilisateur, pensant interagir avec une barre latérale inoffensive, livre en réalité ses secrets commerciaux directement aux serveurs de commande et de contrôle (C2).

L'essentiel Cybersécurité, IA & Tech

Rejoignez la communauté. 3 fois par semaine, recevez l'analyse des tendances par Marc Barbezat. Pas de spam, juste de l'info.

Une infrastructure furtive qui résiste à la désinstallation

La sophistication de cette campagne réside également dans sa capacité à brouiller les pistes et à survivre aux tentatives de nettoyage. Les cybercriminels ont exploité « Lovable », une plateforme de développement web assistée par IA, pour héberger leurs infrastructures périphériques, telles que les pages de politique de confidentialité (chataigpt[.]pro), rendant le traçage vers les acteurs originaux particulièrement ardu. Cette couche d’obfuscation permet au malware de présenter une façade de légitimité, affichant même des badges « En vedette » sur le magasin d’applications avant leur retrait.

Plus pernicieux encore est le mécanisme de défense intégré au code. Si un utilisateur suspicieux tente de supprimer l’une des extensions, le malware déclenche immédiatement l’ouverture d’un nouvel onglet proposant l’installation de la seconde extension vérolée, créant une boucle d’infection difficile à rompre pour un néophyte. Cette persistance agressive démontre une volonté claire de maintenir l’accès aux flux de données aussi longtemps que possible, maximisant ainsi le volume d’informations volées, qu’il s’agisse de requêtes de recherche internes ou de documents confidentiels, comme le rapporte The Hacker News.

Prompt Poaching : Anatomie d’un pillage ciblé

Le terme « Prompt Poaching », littéralement « braconnage de requêtes », désigne l’interception furtive et systématique des échanges entre un humain et une intelligence artificielle générative. Contrairement à un logiciel espion classique qui capture indistinctement les frappes au clavier, cette technique cible spécifiquement la valeur intellectuelle produite lors de ces conversations. Les risques associés sont critiques et immédiats pour les entreprises comme pour les particuliers. L’espionnage industriel figure au premier rang des menaces : les attaquants récupèrent du code source propriétaire, des stratégies commerciales confidentielles ou des données financières sensibles souvent collées dans les chatbots pour analyse.

Au-delà du secret des affaires, ce mécanisme facilite le vol d’identité et l’ingénierie sociale. Les conversations avec l’IA contiennent fréquemment des informations personnelles identifiables (PII) que les utilisateurs livrent dans un contexte de confiance apparente. Ces données permettent ensuite aux cybercriminels de monter des campagnes de phishing contextuel redoutables : en connaissant précisément les sujets de travail ou les préoccupations actuelles d’une cible, ils peuvent forger des leurres d’une crédibilité absolue. Ces informations volées sont ensuite monnayées sur des forums souterrains, transformant la propriété intellectuelle en simple commodité pour réseaux criminels.

Le « Prompt Poaching » contamine aussi les acteurs légitimes

Ce vol de données ne se limite malheureusement pas aux acteurs purement criminels ; une zone grise inquiétante émerge avec des extensions reconnues. Des outils utilisés par des millions de personnes, tels que Similarweb ou Stayfocusd, ont également été pointés du doigt pour des pratiques s’apparentant au « Prompt Poaching ». Dans ces cas, la surveillance des conversations avec l’IA est parfois justifiée par des mises à jour obscures des conditions d’utilisation, mentionnant la collecte des « entrées et sorties IA » pour l’analyse de trafic.

Bien que ces entités légitimes affirment anonymiser les données, la méthode technique reste intrusives : utilisation de scripts pour détourner les API natives du navigateur et récupération de fichiers de configuration distants contenant la logique d’analyse pour Claude, Gemini ou Perplexity. Cette tendance marque un tournant où la conversation privée avec une IA devient une marchandise monétisable, que ce soit par des cybercriminels cherchant à revendre des secrets industriels sur le dark web, ou par des entreprises de marketing avides de statistiques comportementales ultra-précises.

La frontière entre service utile et espionnage se réduit donc dangereusement. Alors que Google examine ces incidents, la persistance de ces extensions sur les stores officiels rappelle que la vigilance individuelle reste le pare-feu le plus efficace : limiter les extensions au strict nécessaire.

Cette veille vous a été utile ?

Un café = un mois de serveur. Aidez DCOD à rester gratuit et indépendant.