TL;DR : L’essentiel

- La Cloud Security Alliance propose quatre nouveaux contrôles (DSP-25 à DSP-28) pour combler les lacunes actuelles, ciblant spécifiquement l’injection de prompts, l’inversion de modèle, la gouvernance de l’apprentissage fédéré et la détection du Shadow AI.

- Les modèles génératifs d’images trahissent souvent les biais de leurs données d’entraînement, comme le démontrent ces générateurs qui représentent systématiquement les cadrans de montres réglés sur 10h10, résistant aux tentatives de correction par réentraînement.

- Des incidents majeurs comme l’exposition de la base de données DeepSeek en 2025 ou la faille d’API d’OpenAI en 2023, où des utilisateurs ont accédé aux historiques de conversation d’étrangers, illustrent les limites des infrastructures actuelles.

- L’adoption de la tokenisation en ligne permet de remplacer les valeurs sensibles par des jetons sécurisés avant leur entrée dans le contexte du modèle, réduisant les risques de fuite accidentelle tout en maintenant l’utilité opérationnelle.

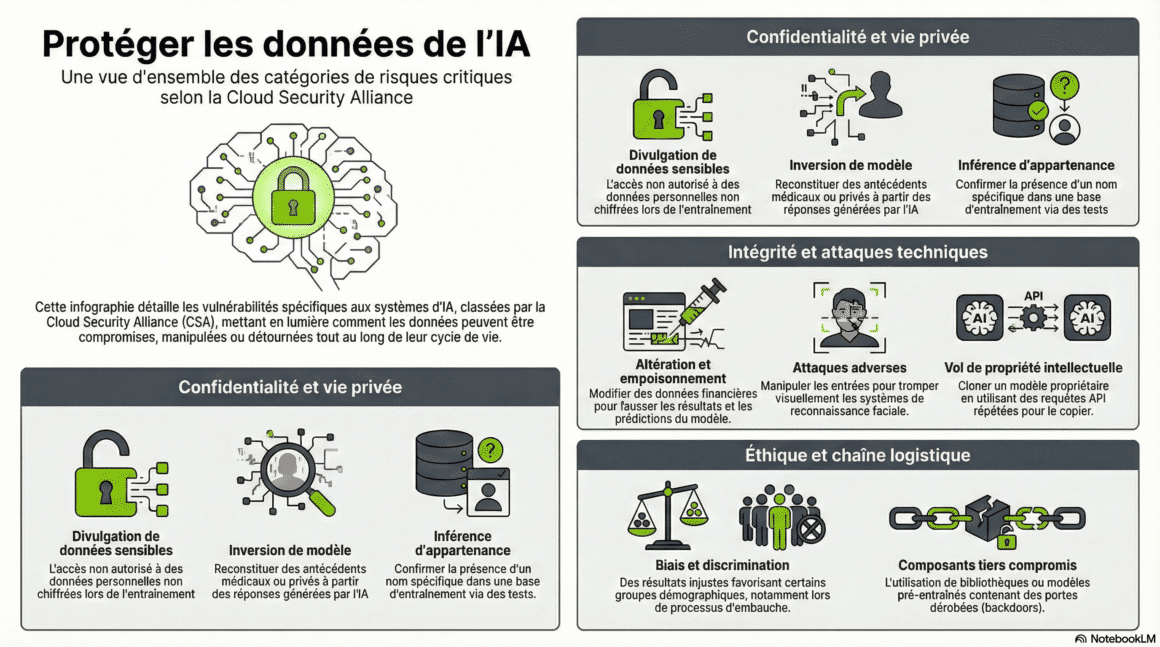

L’intégration de la Matrice AICM devient impérative, car l’approche traditionnelle de la cybersécurité montre ses limites face à l’IA générative. Les systèmes d’IA modernes, caractérisés par des architectures d’apprentissage décentralisées et une dépendance massive aux grands modèles de langage (LLM), imposent une stratégie centrée sur la donnée elle-même. La protection doit désormais s’étendre à l’intégralité du cycle de vie, de la collecte initiale jusqu’à l’inférence, car les vecteurs d’attaque ne visent plus seulement le contenant, mais la manipulation subtile du contenu pour corrompre les résultats ou extraire des informations confidentielles.

Matrice AICM : Quatre nouveaux remparts pour endiguer les fuites

La complexité croissante des systèmes, notamment l’émergence de l’IA multimodale capable de traiter simultanément texte, vidéo et audio, crée des risques de fuites intermodales inédits où une modalité expose les données sensibles d’une autre. Cette convergence brise les silos de sécurité traditionnels : une information visuelle anodine dans une vidéo peut permettre de déduire des données textuelles protégées, créant des vecteurs d’attaque transversaux impossibles à parer avec des filtres unimodaux classiques.

Pour répondre à ces menaces que les sauvegardes périmétriques ne couvrent plus, de nouvelles directives s’imposent pour structurer les interactions génératives. Comme le détaille la Cloud Security Alliance et sa Matrice AICM, l’ajout des contrôles DSP-25 à DSP-28 à la matrice existante devient impératif pour combler ce vide sécuritaire. Ces ajouts ciblent spécifiquement la défense contre l’injection de prompts (pour contrer la manipulation des entrées), la protection contre l’inversion de modèle, la gouvernance de l’apprentissage fédéré et la détection proactive du Shadow AI.

L'essentiel Cybersécurité, IA & Tech

Rejoignez la communauté. 3 fois par semaine, recevez l'analyse des tendances par Marc Barbezat. Pas de spam, juste de l'info.

Ces contrôles visent à combler les failles exploitées par des techniques adverses sophistiquées qui transforment les fonctionnalités du modèle en armes contre lui-même. L’inversion de modèle, par exemple, permet à un attaquant de reconstruire des données d’entraînement sensibles, telles que des dossiers médicaux ou financiers, simplement en analysant les corrélations dans les sorties du système. L’attaquant n’a pas besoin d’accéder à la base de données ; il lui suffit d’interroger le modèle intelligemment pour que celui-ci régurgite ses données d’entraînement, transformant l’API publique en porte dérobée vers des données privées.

🎙️🎧 Plongez au cœur de la sécurité de l’intelligence artificielle avec ce « Deep Dive » audio. Dans cet épisode, nous décortiquons le rapport pivot de la Cloud Security Alliance (CSA) qui redéfinit les règles du jeu face aux IA génératives.

ℹ️ Ce podcast repose sur une recherche et une analyse menées à partir de sources ouvertes et spécialisées. Il a ensuite été réalisé avec l’aide de NotebookLM, l’outil d’intelligence artificielle développé par Google.

Parallèlement, le manque de surveillance des outils d’IA non sanctionnés, ou Shadow AI, crée une dette de sécurité invisible : des gigaoctets de propriété intellectuelle quittent le périmètre de l’entreprise via des copier-coller anodins vers des chatbots grand public, échappant totalement aux radars des équipes de sécurité (SOC) faute de filtrage adéquat sur les flux sortants.

Typologie des risques : Une surface d’attaque en expansion

L’analyse des menaces pesant sur les environnements d’IA révèle une segmentation critique entre les attaques visant l’intégrité durant la phase d’entraînement et celles ciblant la confidentialité lors de l’inférence. Contrairement aux systèmes traditionnels où le vol de données constitue le risque principal, les modèles d’IA sont vulnérables à des manipulations subtiles comme l’empoisonnement de données, où des acteurs malveillants injectent des biais invisibles pour altérer les décisions futures du modèle. Cette vulnérabilité est exacerbée par la nature opaque des réseaux de neurones, rendant la détection de portes dérobées (backdoors) particulièrement complexe sans une traçabilité rigoureuse de la provenance des données (data lineage).

Par ailleurs, comme le rappelle la Matrice AICM, la chaîne d’approvisionnement de l’IA représente un vecteur de compromission systémique souvent sous-estimé. L’intégration massive de bibliothèques tierces non vérifiées et de modèles pré-entraînés open source introduit des risques de « Supply Chain Attacks« , où une seule dépendance compromise peut affecter l’ensemble de l’architecture. Les risques ne se limitent plus à la simple exfiltration, mais s’étendent à la duplication fonctionnelle du modèle lui-même par des requêtes API répétées, permettant le vol de propriété intellectuelle et de logique métier critique sans accès direct aux serveurs.

| Catégorie | Description des risques | Exemples |

|---|---|---|

| Confidentialité des données | Accès ou divulgation non autorisés de données sensibles. | IA entraînée sur des données personnelles sans chiffrement ni anonymisation préalable. |

| Intégrité des données | Altération ou injection de données adverses pour fausser l’apprentissage. | Des données financières modifiées influencent les prédictions boursières du modèle. |

| Inversion de modèle | Reconstitution des données d’entraînement sensibles à partir des sorties (outputs). | Extraction des antécédents médicaux d’un patient via un modèle de diagnostic. |

| Vol de modèles | Clonage de la logique propriétaire ou des poids du modèle. | Rétro-ingénierie d’un modèle de détection de fraude par requêtes API intensives. |

| Biais et équité | Discrimination involontaire ou résultats injustes dus aux données sources. | Modèles de recrutement favorisant certains groupes démographiques au détriment d’autres. |

| Inférence d’appartenance | Déduction de la présence d’une donnée spécifique dans le jeu d’entraînement. | Confirmation qu’un individu spécifique a été utilisé pour entraîner un modèle de sentiment. |

| Attaques adverses | Manipulation des entrées (inputs) pour provoquer des erreurs de classification. | Modification imperceptible de pixels sur une image pour tromper la reconnaissance faciale. |

| Chaîne d’approvisionnement | Compromission via des composants tiers ou dépendances externes. | Portes dérobées (backdoors) insérées dans des modèles NLP pré-entraînés téléchargés. |

Incidents récents : Quand l’infrastructure expose le cœur du modèle

La nécessité de ces nouvelles barrières proposée par la Matrice AICM est corroborée par une série d’incidents techniques critiques survenus ces dernières années. En 2025, une défaillance dans le contrôle d’accès a conduit à l’exposition publique d’une base de données de DeepSeek, révélant des flux de journaux internes et des configurations sensibles. Selon une analyse de Wiz Research, ce cas d’école souligne comment une surveillance insuffisante des infrastructures peut compromettre l’intégralité d’un environnement IA.

D’autres anomalies techniques ont marqué les esprits par leur impact sur la confidentialité des utilisateurs. En 2023, une erreur dans la gestion des sessions de l’API d’OpenAI a permis à certains utilisateurs de visualiser l’historique de chat appartenant à d’autres personnes, brisant ainsi la promesse de cloisonnement des données. Sur le plan de la fiabilité, les biais de données entraînent des hallucinations visuelles persistantes : les générateurs d’images ont tendance à reproduire des stéréotypes visuels, comme des montres affichant invariablement 10h10, reflétant les biais des jeux de données publicitaires initiaux que même le réentraînement peine à corriger.

| Date | Organisation | Type de Risque | Description de l’Incident | Leçons apprises et Meilleures Pratiques |

|---|---|---|---|---|

| 2025 | DeepSeek | Échec du contrôle d’accès et exposition de métadonnées | Une infrastructure d’IA accessible publiquement a exposé une base de données, permettant l’accès aux flux de journaux internes et aux configurations sensibles. | Les systèmes d’IA doivent appliquer une gestion stricte des accès et des protections d’infrastructure, s’étendant aux métadonnées et aux journaux. |

| 2024 | Snowflake | Compromission de la chaîne d’approvisionnement et réutilisation de jetons | Des attaquants ont accédé à des données clients sensibles en exploitant des identifiants volés et une mauvaise hygiène des jetons de session. | Surveillance accrue des plateformes tierces, mise en œuvre du modèle Zero Trust, validation rigoureuse des sessions et politiques de révocation des clés API. |

| 2023 | OpenAI | Fuite de session (API) | Une faille dans la gestion des sessions API a permis à certains utilisateurs de consulter l’historique de clavardage d’autres utilisateurs de GPT-4. | Une utilisation sécurisée des API nécessite une authentification robuste, le chiffrement et l’isolation stricte des sessions pour protéger les prompts sensibles. |

| 2021 | Apache (Log4j) | Vulnérabilité de la chaîne d’approvisionnement | La vulnérabilité Log4Shell a permis l’exécution de code arbitraire sur des infrastructures d’IA et des outils de traitement de données utilisant cette bibliothèque. | Mise en place d’un scannage continu des dépendances, utilisation de SBOM (Software Bill of Materials) et automatisation des flux de correctifs. |

| 2020 | Clearview AI | Données d’entraînement non sécurisées | Une intrusion système a exposé les dossiers clients ainsi que les données d’entraînement utilisées pour la reconnaissance faciale. | Sécurisation des données biométriques par le chiffrement, audits réguliers des tiers et application de politiques d’accès strictes au cycle de vie des données. |

| 2022 | Google DeepMind | Non-conformité à la rétention des données | Des ensembles de données comportementales et médicales ont été conservés au-delà des délais autorisés par les politiques de confidentialité et les réglementations. | La rétention et la suppression des données doivent être gouvernées tout au long du pipeline d’IA via des audits de conformité réguliers. |

| 2019 | Risque de confidentialité basé sur l’inférence | Le système de ciblage publicitaire pouvait inférer des attributs sensibles des utilisateurs sans leur consentement explicite. | Application de méthodes de préservation de la vie privée comme la confidentialité différentielle et l’apprentissage fédéré pour limiter les risques d’inférence. |

Conformité et défense : L’urgence d’une stratégie Zero Trust

Face à ces vulnérabilités, le paysage réglementaire se durcit avec l’entrée en vigueur de cadres stricts comme l’EU AI Act ou les directives du NIST. Les organisations doivent désormais prouver la traçabilité de leurs données et la robustesse de leurs modèles. Le NIST recommande une gestion des risques socio-techniques qui englobe l’intégrité des données et l’explicabilité. En pratique, cela se traduit par l’adoption de technologies de protection de la vie privée (PETs) et de mécanismes de chiffrement avancés, comme le chiffrement homomorphe, qui permet le traitement des données sans les déchiffrer.

La tokenisation en ligne s’impose également comme une mesure défensive clé. Elle agit comme un garde-fou en temps réel, remplaçant les éléments sensibles par des jetons avant qu’ils n’atteignent le modèle. Cette technique, couplée à une architecture Zero Trust qui vérifie continuellement chaque accès, permet de limiter le « blast radius » en cas de compromission d’identifiants. Pour les secteurs critiques, l’intégration d’un « kill-switch » ou mécanisme d’arrêt d’urgence est désormais envisagée pour stopper net un système dont le comportement deviendrait aberrant ou dangereux.

L’ère de la sécurité périmétrique est révolue pour laisser place à une gouvernance granulaire et dynamique comme le propose Matrice AICM. La résilience des systèmes d’intelligence artificielle ne dépend plus seulement de la solidité des murs qui les entourent, mais de la pureté et de la protection des données qui les alimentent, obligeant les experts à une vigilance constante sur l’ensemble de la chaîne de valeur algorithmique.

FAQ : Comprendre la sécurité de l’IA

Qu’est-ce que la Cloud Security Alliance (CSA) ?

C’est une organisation mondiale à but non lucratif qui définit les meilleures pratiques pour sécuriser l’informatique en nuage (Cloud Computing) et désormais l’Intelligence Artificielle. Elle édite des standards et des certifications de référence pour l’industrie.

À quoi sert la Matrice AICM (AI Controls Matrix) ?

C’est un cadre de référence développé par la CSA, listant l’ensemble des contrôles de sécurité et de conformité applicables aux systèmes d’IA. C’est une « check-list » technique permettant aux organisations d’évaluer et de renforcer la sécurité de leurs modèles.

En quoi consiste la tokenisation ?

C’est un procédé de sécurité consistant à remplacer une donnée sensible (comme un numéro de carte bancaire ou un nom) par une valeur aléatoire équivalente appelée « jeton » (token). Le jeton n’a aucune valeur intrinsèque s’il est volé, car seule la base de données sécurisée permet de faire le lien avec la donnée réelle.

Que sont les Grands modèles de langage (LLM) ?

C’est un type d’intelligence artificielle entraînée sur d’immenses quantités de texte pour comprendre et générer du langage humain. GPT-4 ou Claude sont des exemples de LLM. Ils sont capables de raisonner, résumer et traduire, mais sont vulnérables aux biais et aux injections.

Qu’appelle-t-on le Shadow AI ?

Cela désigne l’utilisation non officielle ou non approuvée d’outils d’IA par les employés d’une entreprise (ex: utiliser ChatGPT personnel pour rédiger un rapport confidentiel). Cette pratique échappe au contrôle du service informatique et expose l’entreprise à des fuites de données.

Qu’est-ce que l’apprentissage fédéré ?

C’est une méthode d’entraînement où l’IA apprend directement sur les appareils des utilisateurs (smartphones, objets connectés) sans que les données brutes ne soient envoyées vers un serveur central. Seules les mises à jour du modèle sont partagées, ce qui préserve la vie privée mais introduit des risques de manipulation par des appareils malveillants.

En quoi consiste l’attaque par inversion de modèle ?

C’est une technique d’attaque où un pirate tente de reconstruire les données brutes (souvent confidentielles) utilisées pour entraîner une IA en analysant simplement ses réponses. Par exemple, il pourrait retrouver l’image d’un visage spécifique à partir d’un système de reconnaissance faciale.

Qu’est-ce qu’une attaque par inférence d’appartenance ?

C’est un type d’attaque où un pirate interroge un modèle d’IA pour déterminer si les données d’une personne spécifique ont été utilisées lors de son entraînement. Cela viole directement la confidentialité et peut révéler l’appartenance d’un individu à un groupe sensible (ex: patients d’un hôpital).

Comment fonctionnent les « Supply Chain Attacks » (Attaques de la chaîne d’approvisionnement) ?

Ce sont des cyberattaques qui ne ciblent pas directement l’entreprise finale, mais ses fournisseurs ou les logiciels tiers qu’elle utilise. Dans l’IA, cela consiste souvent à corrompre une bibliothèque open-source ou un modèle pré-entraîné utilisé par des milliers de développeurs.

Qu’est-ce que la stratégie Zero Trust ?

C’est un modèle de sécurité qui part du principe qu’aucune entité, qu’elle soit à l’intérieur ou à l’extérieur du réseau, ne doit être approuvée par défaut. Chaque demande d’accès est vérifiée en continu (identité, contexte, appareil), minimisant les risques en cas de vol d’identifiants.

Cette veille vous est utile ?

Offrez un café pour soutenir le serveur (et le rédacteur).