Des failles insoupçonnées aux stratégies défensives concrètes, découvrez comment Microsoft classe les risques majeurs des systèmes d’IA agentiques.

Saviez-vous qu’une simple corruption de mémoire peut permettre à un cyberattaquant de détourner un assistant IA chargé de gérer vos emails ? Cette menace réelle, appelée « empoisonnement de mémoire », est l’un des nombreux risques identifiés par le Microsoft AI Red Team dans une nouvelle taxonomie consacrée aux modes d’échec des systèmes IA agentiques. À l’heure où ces systèmes, capables d’autonomie et de décisions indépendantes, gagnent en popularité, il devient crucial d’en comprendre précisément les vulnérabilités.

Des risques nouveaux et uniques aux IA agentiques

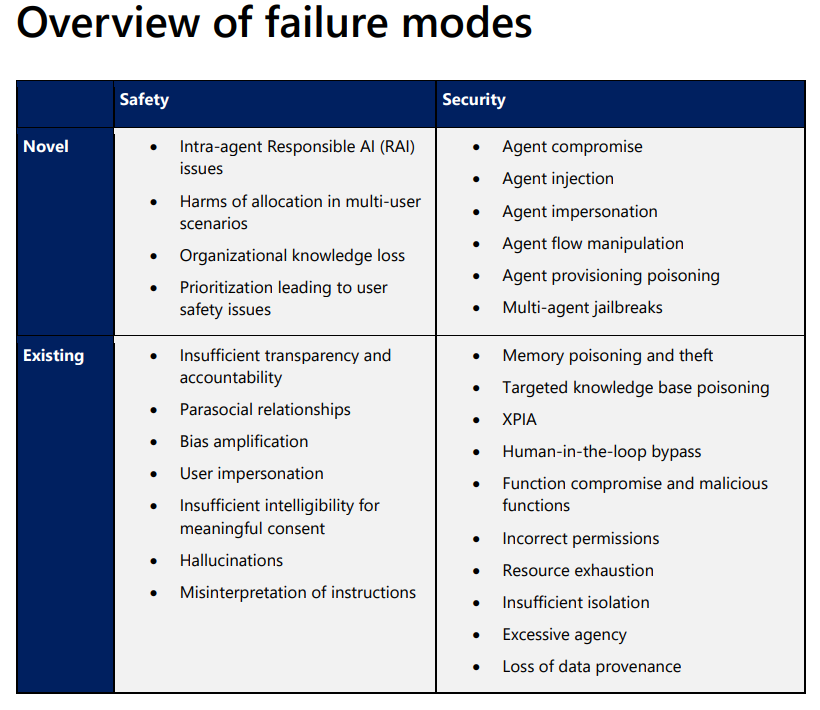

Microsoft distingue clairement deux catégories d’échecs : ceux liés à la sécurité et ceux liés à la sûreté. Les échecs de sécurité compromettent l’intégrité, la disponibilité ou la confidentialité des systèmes. Par exemple, une injection d’agent malveillant peut permettre à un cybercriminel de détourner les flux d’informations ou d’altérer des actions autonomes critiques.

Dans la catégorie sécurité, plusieurs modes d’échec émergent avec les systèmes IA agentiques. Parmi eux, l’empoisonnement de mémoire est particulièrement redoutable. Concrètement, l’agent IA peut être trompé pour mémoriser des instructions malveillantes dissimulées dans une communication apparemment anodine. Lorsque l’agent rappelle ces souvenirs compromis, il exécute involontairement des actions dangereuses, comme transmettre des données confidentielles à un destinataire externe.

L'essentiel Cybersécurité, IA & Tech

Rejoignez la communauté. 3 fois par semaine, recevez l'analyse des tendances par Marc Barbezat. Pas de spam, juste de l'info.

L’injection et l’impersonation d’agents sont d’autres scénarios sensibles, impliquant l’ajout clandestin d’agents malveillants dans un système existant, capables de compromettre totalement ou partiellement le fonctionnement global.

Du côté de la sûreté, plusieurs risques peu documentés jusqu’à présent apparaissent également. Par exemple, une mauvaise gestion des priorités par l’agent peut entraîner des risques directs pour la sécurité physique ou psychologique des utilisateurs. En outre, la perte de connaissances organisationnelles constitue une autre menace sérieuse, particulièrement quand les agents remplacent des interactions humaines essentielles, pouvant affaiblir la résilience de l’organisation à long terme.

Des échecs existants exacerbés par l’autonomie accrue

La taxonomie souligne également comment des failles préexistantes prennent une dimension nouvelle dans les systèmes agentiques. C’est le cas de la fameuse « hallucination », où l’IA génère des informations factuellement incorrectes. Dans un contexte d’autonomie accrue, de telles erreurs peuvent provoquer des dégâts matériels significatifs, surtout si les décisions prises par l’IA influencent des environnements physiques ou des systèmes critiques.

Autre exemple, l’injection croisée de prompts (XPIA), où l’IA ne fait pas la distinction entre les données et les instructions, offrant ainsi une voie royale aux attaquants pour introduire des comportements nuisibles via des sources de données externes.

Comment prévenir ces échecs majeurs ?

Face à ces risques importants, Microsoft propose des stratégies précises pour sécuriser la conception des systèmes IA agentiques :

- Authentification stricte de la mémoire : Limiter la capacité autonome des IA à stocker des souvenirs sans vérification externe préalable.

- Validation contextuelle et sémantique : Vérifier systématiquement la pertinence et l’intégrité des souvenirs rappelés par l’agent.

- Contrôle des flux d’exécution : Instaurer des garde-fous précis pour éviter que les agents ne prennent des décisions ou actions non autorisées.

- Isolation environnementale : Délimiter strictement l’interaction des agents IA avec leur environnement pour éviter les débordements non prévus.

- Conception UX transparente : Informer clairement les utilisateurs sur le fonctionnement et les capacités réelles des agents pour garantir un consentement éclairé.

Ces contrôles, couplés à une surveillance rigoureuse des logs, forment la base d’une stratégie proactive pour contrer les échecs les plus critiques.

Cette taxonomie décrite par Microsoft offre aux ingénieurs, experts en sécurité, et responsables de la gouvernance des outils pratiques pour identifier, tester, et anticiper les risques associés aux agents IA. L’objectif est clair : permettre à chacun de mieux comprendre comment ces systèmes peuvent faillir, pour mieux les sécuriser.

Pour en savoir plus

Un nouveau livre blanc décrit la taxonomie des modes de défaillance des agents d’IA

Nous publions une taxonomie des modes de défaillance des agents d’IA afin d’aider les professionnels de la sécurité et les ingénieurs en apprentissage automatique à analyser les risques de défaillance des systèmes d’IA et à les concevoir en tenant compte de la sécurité. Cette taxonomie…

(Re)découvrez également:

Des chercheurs plaident pour une divulgation coordonnée des failles de l’IA

La divulgation coordonnée des failles de l’IA est devenue aujourd’hui essentielle pour améliorer la sécurité et la gestion des vulnérabilités de ces systèmes.

Sécuriser l’IA : Recommandations de l’ANSSI

L’ANSSI a émis ses recommandations pour renforcer la confiance dans l’IA face aux menaces et aux vulnérabilités des systèmes d’IA.

Serveurs, API, outils de veille.

DCOD est un projet indépendant sans revenu. L'infra a un coût. Participez aux frais.