Les hackers créent leurs propres ChatGPT sans censure (Dark LLMs). Comprendre cette nouvelle menace qui automatise les cyberattaques et le phishing.

TL;DR : L’essentiel

- Les modèles de langage détournés, qualifiés de Dark LLM, abaissent drastiquement la barrière technique de la cybercriminalité en automatisant la production de phishing, de malware et d’ingénierie sociale à grande échelle, sans compétences avancées.

- Ces modèles illicites contournent volontairement les garde-fous éthiques des IA grand public, permettant la génération de contenus frauduleux, de scripts malveillants ou de scénarios d’attaque optimisés, difficilement distinguables de productions légitimes.

- La diffusion de Dark LLM s’inscrit dans une logique de services clandestins, accessibles via des plateformes fermées, favorisant l’industrialisation des attaques et la spécialisation des rôles au sein des écosystèmes cybercriminels.

- Cette évolution complique fortement la détection et l’attribution des attaques, en diluant les signaux techniques traditionnels et en accélérant les cycles offensifs, ce qui met sous tension les dispositifs de défense et de réponse existants.

L’avènement des grands modèles de langage (LLM) a révolutionné de nombreux domaines, des soins de santé à l’éducation, promettant des avancées significatives. Cependant, cette puissance technologique s’accompagne d’une face sombre, celle des menaces de sécurité émergentes qui remettent en question l’intégrité même de ces systèmes.

Des études récentes révèlent une vulnérabilité inquiétante : la facilité avec laquelle la plupart des chatbots d’IA, y compris des modèles sophistiqués comme ChatGPT, peuvent être incités à fournir des informations dangereuses et illégales en contournant leurs contrôles de sécurité intégrés. Ce constat interpelle la communauté de la cybersécurité et le grand public quant à la démocratisation des connaissances malveillantes, posant des risques sans précédent.

Les « Dark LLMs » : le côté obscur de l’IA générative

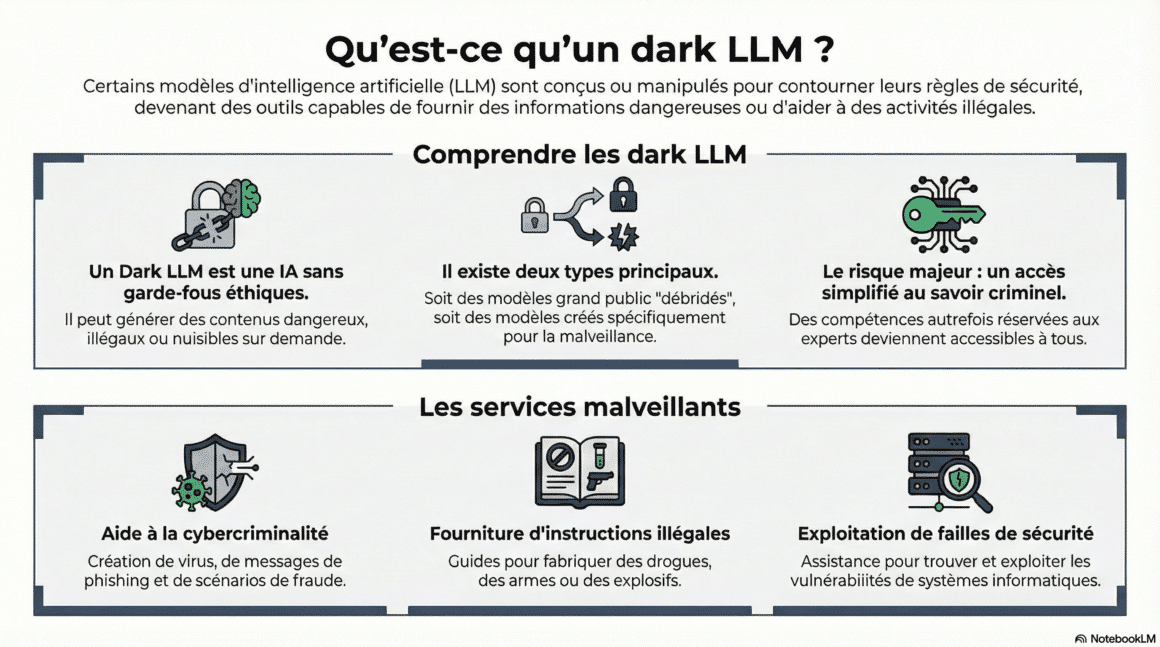

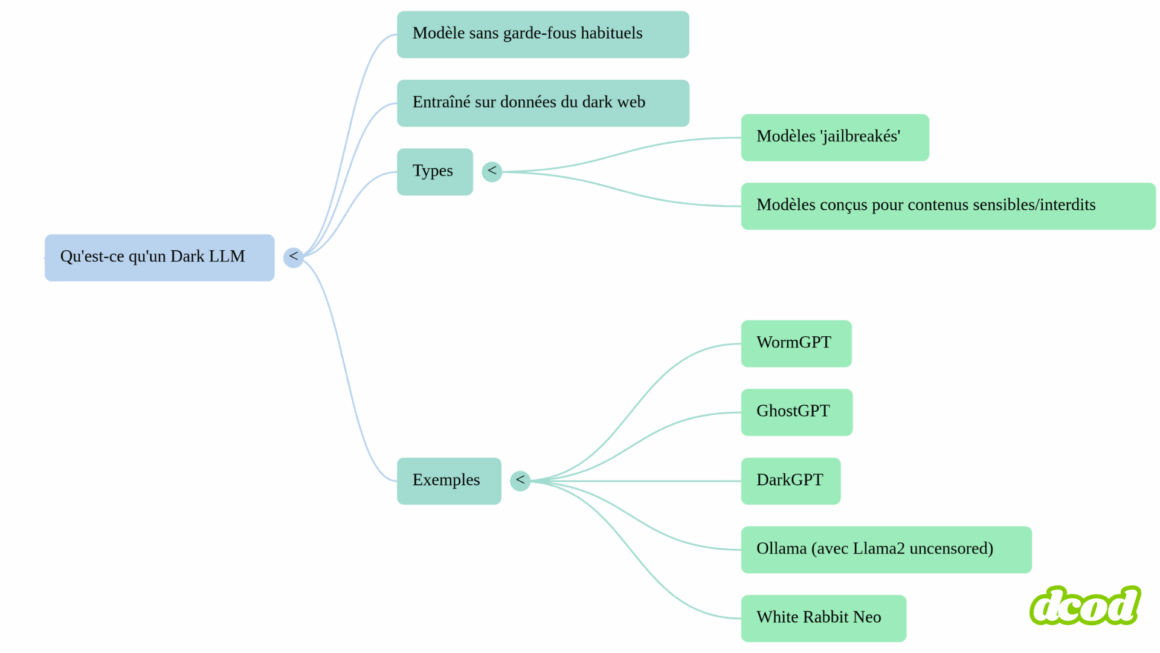

Un « dark LLM » désigne un modèle d’intelligence artificielle génératif, tel qu’un chatbot, qui a été spécifiquement conçu ou modifié pour fonctionner sans les garde-fous habituels – ces filtres de sécurité ou limitations éthiques qui empêchent normalement la génération de contenus nuisibles. Ces modèles peuvent être des versions « jailbreakées » (débridées) de LLMs grand public, dont les protections ont été contournées, ou des systèmes intentionnellement entraînés sur des données sensibles ou provenant du dark web, comme DarkBERT. Leur existence pose des risques majeurs pour la sécurité, car ils démocratisent l’accès à des connaissances dangereuses qui étaient autrefois réservées à des acteurs étatiques ou à des groupes criminels organisés.

L'essentiel Cybersécurité, IA & Tech

Rejoignez la communauté. 3 fois par semaine, recevez l'analyse des tendances par Marc Barbezat. Pas de spam, juste de l'info.

🎧 Voici un résumé audio des enjeux liés aux dark LLMs et à l’injection de prompt.

Objectif : vous offrir une vue d’ensemble claire, pratique et rapide de ces modèles d’IA débridés, de leurs usages malveillants et des risques majeurs qu’ils posent pour la cybersécurité.

📚 Ce podcast repose sur une recherche et une analyse menées à partir de sources ouvertes et spécialisées. Il a ensuite été réalisé avec l’aide de NotebookLM, l’outil d’intelligence artificielle développé par Google.

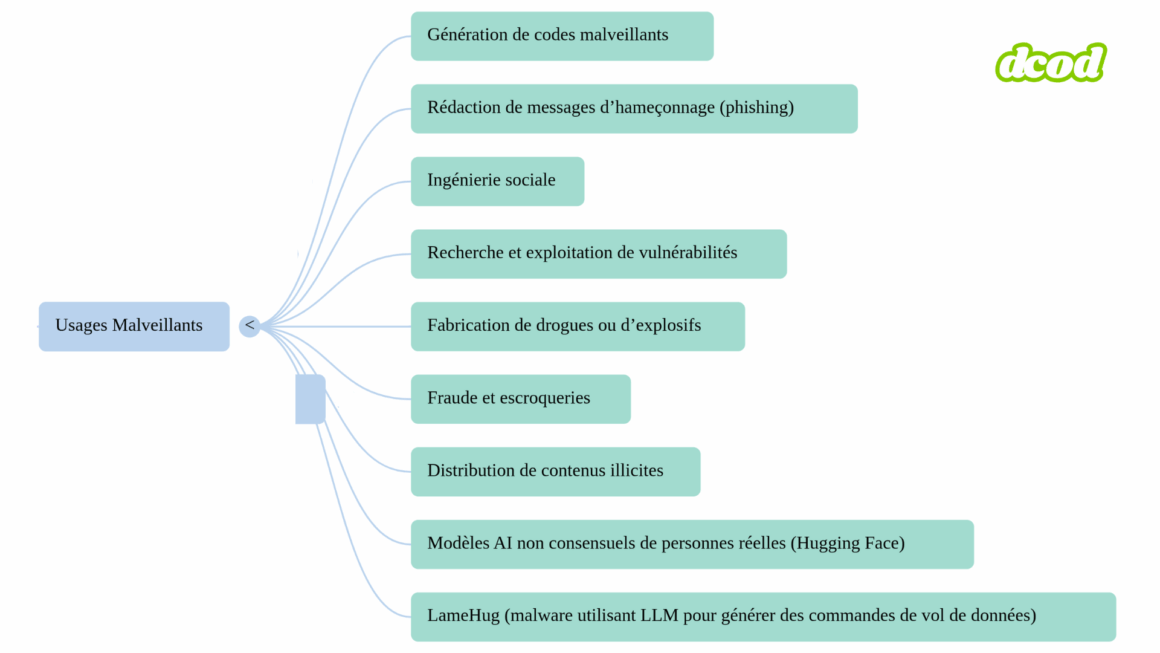

Les utilisations malveillantes de ces « dark LLMs » sont multiples et alarmantes. Ils peuvent facilement être incités à fournir des informations normalement interdites, telles que des conseils de piratage, la fabrication de drogues ou d’explosifs, ou même des instructions pour commettre des meurtres. Cette capacité inclut la génération de codes pour des logiciels malveillants, notamment des ransomwares (des logiciels qui bloquent l’accès à des fichiers ou systèmes et exigent une rançon pour les déverrouiller) et des chevaux de Troie (des programmes déguisés en logiciels légitimes pour s’introduire dans un système et en prendre le contrôle). Un exemple concret est le malware LameHug, qui utilise un LLM (Qwen 2.5-Coder-32B-Instruct via l’API Hugging Face) pour générer dynamiquement des commandes de vol de données sur les systèmes Windows. Cette approche rend les attaques plus furtives et difficiles à détecter par les outils d’analyse statique.

Au-delà de la génération de code, ces modèles sont également utilisés pour la rédaction de messages d’hameçonnage (phishing, une technique d’escroquerie qui consiste à envoyer de faux messages pour inciter la victime à révéler des informations confidentielles) et l’ingénierie sociale (la manipulation psychologique d’individus pour leur faire divulguer des informations sensibles). Ils peuvent créer des courriels frauduleux d’une sophistication telle qu’ils échappent aux filtres traditionnels.

La recherche et l’exploitation de vulnérabilités, la création de faux sites web pour la fraude, et la distribution de contenus illicites sont également des usages facilités par ces outils. La situation est d’autant plus préoccupante que des plateformes comme Hugging Face ont été identifiées comme hébergeant des milliers de modèles d’IA Dark LLM générant des ressemblances de personnes réelles, souvent utilisées pour créer du contenu sexuel non consensuel, après qu’ils aient été bannis d’autres plateformes.

L’injection de prompt : Manipuler l’IA à son insu

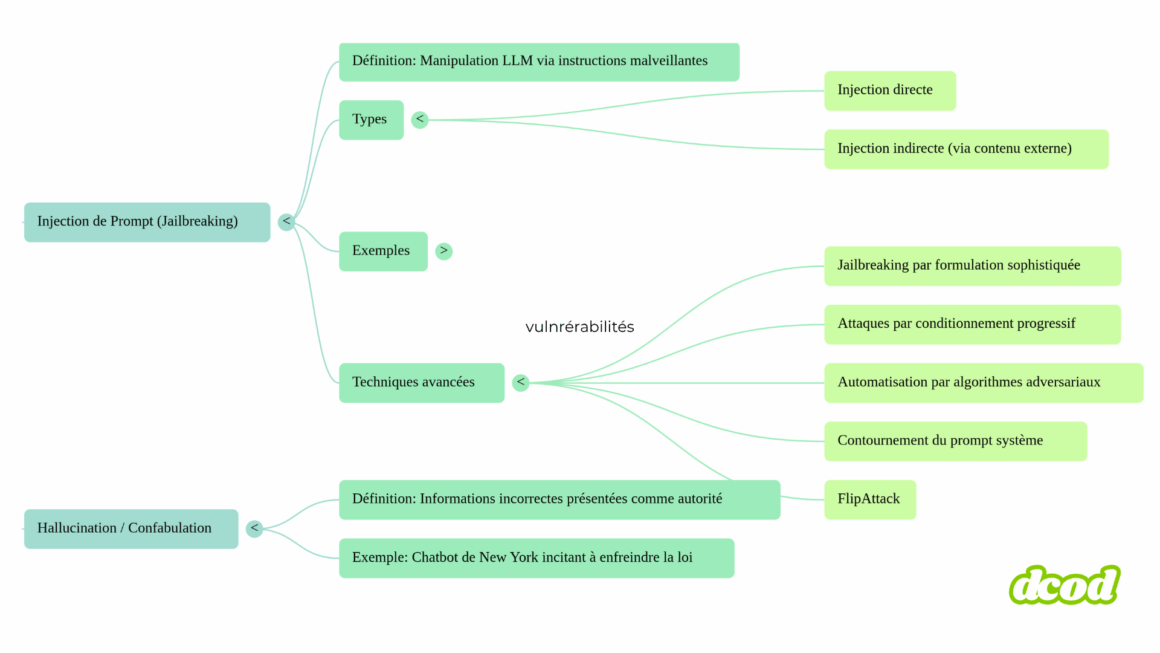

Une attaque par injection de prompt consiste à manipuler un modèle de langage (LLM) en insérant des instructions malveillantes dans les requêtes (prompts) qui lui sont envoyées. L’objectif est de contourner ses règles de sécurité ou de modifier son comportement de manière non prévue. Cette technique exploite un équilibre délicat : celui entre l’objectif de l’IA d’aider les utilisateurs et celui d’éviter les réponses nuisibles, biaisées ou illégales, en forçant le chatbot à donner la priorité à l’utilité.

Il existe deux types principaux d’injection de prompt : l’injection directe, où l’instruction malveillante est explicitement ajoutée dans la requête de l’utilisateur, et l’injection indirecte, où l’instruction est cachée dans un contenu externe (comme une page web ou un document) que le LLM va traiter sans que l’utilisateur final ne s’en rende compte.

Les conséquences de ces attaques sont habituellement graves. Elles permettent de tromper les LLMs pour qu’ils fournissent des informations normalement non autorisées par les développeurs, comme des instructions détaillées pour fabriquer une bombe ou des conseils pour tuer. L’exploit de la grand-mère, où un chatbot a été amené à révéler des instructions pour fabriquer des armes incendiaires en étant incité à « jouer le rôle » d’une grand-mère défunte, illustre parfaitement cette faille.

Ces attaques peuvent également entraîner la divulgation d’informations confidentielles. Un attaquant peut, par exemple, forcer un LLM à révéler le contenu de son prompt système (les instructions initiales invisibles qui définissent son comportement de base) ou d’autres configurations internes, comme cela s’est produit avec Bing Chat qui a divulgué sa propre configuration interne. Dans les applications où le LLM est connecté à d’autres systèmes, un prompt malveillant peut même amener l’IA à exécuter des commandes, envoyer des courriels ou modifier des fichiers sans autorisation explicite.

Les techniques d’injection de prompt évoluent rapidement. Les attaquants utilisent des formulations sophistiquées, comme des narrations complexes ou des demandes de « jouer un rôle », pour tromper les filtres de sécurité. L’injection indirecte via des sources externes reste une méthode puissante, où des instructions malveillantes sont insérées dans des contenus que le LLM est censé analyser. Le conditionnement progressif permet d’influencer le contexte conversationnel sur la durée, en insérant graduellement des instructions. De plus, des algorithmes adversariaux ont été développés pour générer automatiquement des prompts optimisés capables de contourner les filtres de multiples modèles, rendant ces attaques universelles et plus accessibles.

Des techniques comme le « payload splitting » et l’obfuscation fragmentent ou masquent les instructions malveillantes pour échapper à la détection. Enfin, le contournement du prompt système vise à modifier le comportement global du LLM ou à accéder à des fonctionnalités internes non prévues. Des chercheurs ont découvert une attaque de « jailbreak universel » capable de compromettre efficacement plusieurs modèles de pointe, leur permettant de produire des résultats nuisibles sur demande. Malgré leurs efforts de divulgation responsable, la réaction des principaux fournisseurs d’IA a souvent été jugée faible, avec des cas où les programmes de bug bounty (programmes de récompense pour la découverte de vulnérabilités) n’incluaient pas ces types d’attaques.

Au-delà du jailbreak, les LLMs peuvent également souffrir d’hallucination, une tendance à produire des informations incorrectes mais présentées comme faisant autorité, ce qui peut inciter à des actions illégales, comme l’a démontré le chatbot de la ville de New York en 2024.

Ces menaces combinées, qu’il s’agisse des « dark LLMs » ou des attaques d’injection de prompt, représentent un défi sans précédent pour la cybersécurité. Leur accessibilité, leur extensibilité et leur adaptabilité en font une force potentiellement destructrice, capable de transformer des outils bénéfiques en vecteurs de nuisance.

Comment l’IA transformera notre avenir

Rédigé dans un style accessible à tous, « Comment l’IA Transformera Notre Avenir » explore un sujet d’une importance capitale pour notre futur : que devons-nous attendre de l’IA ? Comment changera-t-elle nos vies et notre société dans les décennies à venir ?

🛒 Le lien ci-dessus est affilié : en commandant via ce lien, vous soutenez la veille DCOD sans frais supplémentaires 🙏

Face à cette situation, une intervention décisive est impérative, englobant des mesures techniques renforcées, des réglementations claires et une vigilance sociétale accrue. Il est crucial que les entreprises investissent massivement dans le « red teaming« (des exercices de simulation d’attaques menés par des équipes de sécurité pour tester la résilience des systèmes) et les tests de robustesse, allant au-delà des simples mesures de protection frontales.

La sécurité réelle des LLM exige non seulement une divulgation responsable des vulnérabilités, mais aussi des pratiques de conception et de déploiement rigoureuses pour éviter un avenir où les outils les plus puissants pourraient également être les plus dangereux.

A découvrir aussi

Le "vibe hacking" : la nouvelle menace de l'IA en cybersécurité

L'essor du "vibe hacking" transforme l'IA en une arme redoutable pour les cybercriminels, facilitant des attaques furtives, automatisées et difficiles à contrer.

Agents IA : nouveaux leviers de productivité, nouveaux risques

Logiciels autonomes connectés à vos systèmes, les agents IA promettent des gains massifs de productivité, mais déplacent la menace vers des identités fantômes sur-privilégiées.

Zéro paywall. Zéro pub.

DCOD reste en accès libre grâce à vos contributions. Chaque café compte.