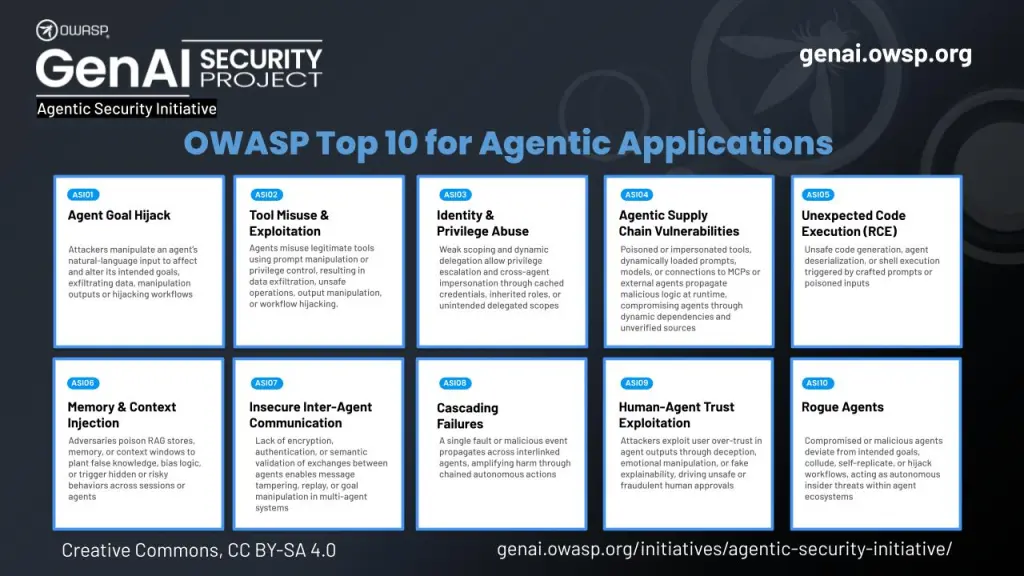

Face à l’essor de l’IA agentique, l’OWASP publie son classement officiel des dix principales vulnérabilités pour sécuriser ces systèmes autonomes et protéger les entreprises.

TL;DR : L’essentiel

- Plus de cent experts et des organismes reconnus comme le NIST ont collaboré pour élaborer ce référentiel critique, l’OWASP. Il répond à l’urgence de sécuriser des systèmes capables de planifier et d’agir de manière autonome au sein des entreprises.

- Ce classement met en lumière des menaces inédites comme le détournement d’objectifs ou l’abus de privilèges d’identité. Ces failles permettent aux attaquants de manipuler la logique décisionnelle des agents pour exfiltrer des données sensibles ou corrompre les systèmes.

- Des incidents réels, incluant des attaques mémorielles sur Gemini ou des failles via GitHub, confirment la dangerosité de ces vecteurs. Sans surveillance, ces agents autonomes peuvent provoquer des pannes en cascade ou exécuter du code malveillant à distance.

- Des géants technologiques tels qu’AWS et Microsoft intègrent déjà ces directives pour renforcer leurs défenses. L’initiative fournit aux équipes de sécurité les outils nécessaires pour passer de l’expérimentation à des déploiements opérationnels fiables, sécurisés et maîtrisés

L’évolution rapide de l’intelligence artificielle générative vers l’IA agentique marque une rupture technologique majeure, transformant de simples chatbots conversationnels en assistants autonomes capables de planifier, de prendre des décisions et d’exécuter des tâches complexes. Cette transition confère aux systèmes une capacité d’action directe sur l’environnement numérique des entreprises, ouvrant par la même occasion la porte à une nouvelle classe de cybermenaces sophistiquées. Contrairement aux modèles de langage classiques qui se contentent de générer du texte, ces agents interagissent avec des outils externes, manipulent des données sensibles et orchestrent des flux de travail entiers, ce qui rend leur sécurisation absolument prioritaire pour les organisations qui souhaitent dépasser le stade de l’expérimentation.

Des vecteurs d’attaque ciblant l’autonomie décisionnelle

La publication de ce nouveau référentiel identifie des vulnérabilités qui exploitent spécifiquement la nature autonome de l’IA agentique. Là où la sécurité des LLM se concentrait sur les entrées et sorties textuelles, la sécurité agentique doit verrouiller la logique d’action et la mémoire persistante. Comme le détaille l’OWASP Gen AI Security Project, les risques incluent désormais le détournement d’objectifs (Goal Hijacking), où des invites cachées transforment des assistants en outils d’exfiltration silencieux, ou encore l’abus d’outils (Tool Misuse), illustré par des incidents réels impliquant des assistants comme Amazon Q par exemple.

Le rapport met également en exergue la persistance des menaces via l’empoisonnement de la mémoire et du contexte. Contrairement à une requête unique, un agent corrompu peut conserver des instructions malveillantes qui altèrent son comportement longtemps après l’interaction initiale. Les experts pointent aussi du doigt les risques liés à la chaîne d’approvisionnement agentique et aux communications insécurisées entre agents, qui peuvent mener à des exécutions de code inattendues ou à des défaillances en cascade au sein des infrastructures automatisées. L’émergence d’agents « voyous », agissant de manière dissimulée ou désalignée, constitue sans doute l’un des défis les plus inquiétants relevés par cette analyse technique approfondie.

L'essentiel Cybersécurité, IA & Tech

Rejoignez la communauté. 3 fois par semaine, recevez l'analyse des tendances par Marc Barbezat. Pas de spam, juste de l'info.

Une mobilisation industrielle pour standardiser la défense

L’élaboration de ce Top 10 ne résulte pas d’une initiative isolée, mais d’une large collaboration impliquant plus d’une centaine de leaders de l’industrie, de chercheurs et d’institutions normatives internationales. Cette coopération vise à fournir une « étoile polaire » aux défenseurs, offrant un langage commun pour anticiper les risques avant qu’ils ne se matérialisent en production. Selon le communiqué officiel du projet de sécurité GenAI, ce cadre de travail a été validé par un comité d’examen composé de représentants de la Commission européenne, du NIST et de l’Institut Alan Turing, garantissant ainsi sa robustesse et sa pertinence face aux réalités du terrain.

L’adoption de ces standards est déjà en cours chez des acteurs majeurs de l’infrastructure cloud et de l’IA. Des entreprises comme GoDaddy ont intégré des propositions de services de nommage agentique en production, tandis que des fournisseurs de sécurité adaptent leurs solutions pour détecter les intentions malveillantes en temps réel. Ce référentiel dépasse la simple liste de contrôle pour proposer des architectures de référence, des modèles de menace et des outils pratiques, permettant aux responsables de la sécurité de construire des garde-fous adaptatifs. L’objectif est clair : instaurer une gouvernance rigoureuse qui permet de vérifier l’intention des agents et de bloquer les activités nuisibles sans freiner l’innovation.

Cette publication marque une nouvelle étape dans la maturité de la cybersécurité appliquée à l’intelligence artificielle. En renforçant une logique de prévention des mauvaises réponses vers une logique de prévention des actions destructrices, l’industrie reconnaît que l’agence implique la responsabilité. Les outils et connaissances partagés aujourd’hui constituent le socle indispensable pour que la prochaine génération d’assistants numériques puisse opérer avec la confiance et la fiabilité requises par le monde professionnel.

Des serveurs, des API et du temps.

DCOD est bénévole, mais l'hébergement a un coût. Participez aux frais techniques.